时长:

60分钟

播放:

1.58万

发布:

1年前

主播...

简介...

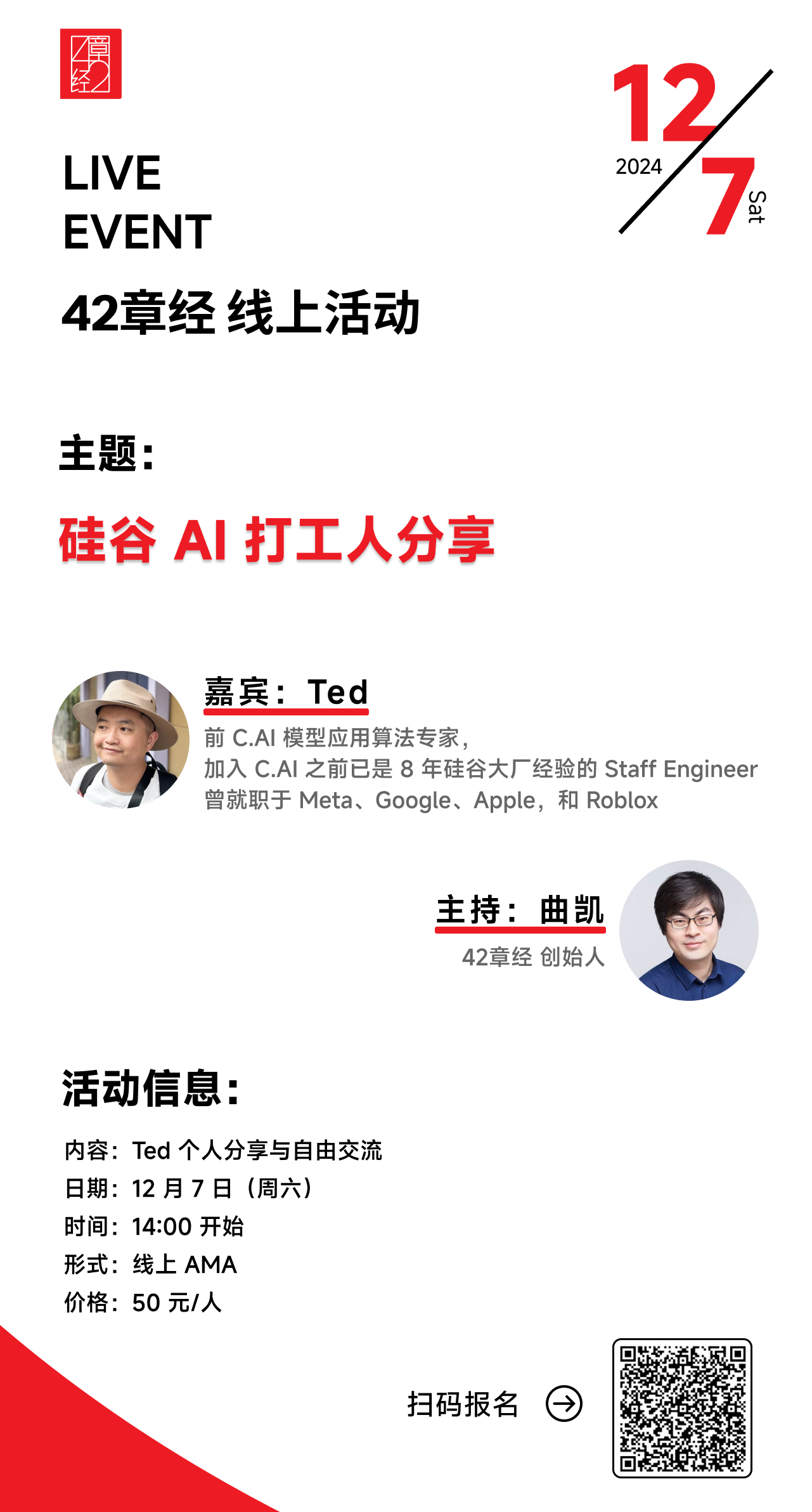

活动预告🥳:12 月 7 日,我们会请到 Ted 做一场线上活动,大家记得翻到 shownotes 末尾查看报名信息!

在我 9 月份的硅谷行程里,我见过的印象最深、让我最有收获的人之一就是 Ted。

那个时候他正要离开 Character.ai,作为第四十多号加入的员工,他对于 C.AI 的产品、模型、训练等等的熟悉程度都非常高,这次很开心能把他请来,跟大家一起分享下美国最著名的 AI 公司内部是如何运作的,Post Training 的最佳实践是怎么做的,以及硅谷一众 AI 从业者的现状和认知等。

这期播客的内容基本代表了美国最一线的 AI 从业者的实践和认知,非常有代表性,希望对大家有帮助!

最后,我们的 AI 私董会也在持续报名中,目前已经聚集了一批市场上最好的 AI 创始人,欢迎点击链接报名(里面也有目前已加入的成员名单,可点击查看)

【人类博物馆】

导游:曲凯,42章经创始人

28 号珍藏:Ted,前 C.AI 模型应用算法专家

Part 1 从内部视角看 C.AI

- 01:06 为什么商业化一直没做起来?

- 04:40 如果 C.AI 当时往 AGI 赌把大的,或者把产品交给字节系,能改写自己的结局吗?

- 06:51 我们很认可 Talkie,但不想学 Talkie

- 09:36 被收购后,你还相信 C.AI 类产品的未来吗?

- 11:35 有人说「C.AI 不是真正的 AI 陪伴」,那它到底是啥?

- 12:19 C.AI 为什么做得比别人好?

Part 2 我在 C.AI 做 Post Training 的这一年

- 14:56 工作状态是 996(主动的哈,passion!

- 17:15 Post Training 的核心是设计高效的迭代路径

- 18:42 四种迭代路径,都有很多低垂的果实可以摘

- 21:40 怎么评估和改善「模型变蠢」的问题?

- 22:54 迭代中一个有趣的 EQ 涌现

- 24:19 Post Training 到底是怎么个流程?

- 25:37 介绍 Post Training 三大件:SFT(监督微调) 、RLHF(人类反馈强化学习)、DPO (直接偏好对齐)

- 32:07 以上天花板极高,RAG 和 Prompt Engineering 我们几乎没做

- 32:53 帮你拉开和同行差距的 2 道数据思考题:

- 33:18 你微调用的数据,质量真的不能更高了吗?

- 36:00 收集来的用户偏好数据,只能是点赞点踩吗?

- 39:32 大家现在关注的几个技术难题,C.AI 是怎么做的?

- 39:49 怎么做好评估?

- 41:10 怎么做好意图识别?

- 43:22 C.AI 的语音延迟基本是业界做得最好的,是怎么做到的?

Part 3 硅谷观察

- 46:17 一个不被公开的秘密:ChatGPT 内部也是多模型混用?

- 47:28 硅谷整体还是很乐观,推理侧仍然大有可为

- 50:45 硅谷现状:

- 51:01 做产品的想靠多模态赚钱

- 51:06 搞算法的想复制 o1

- 51:16 两边都在期待自动交互 Agent 解锁的想象空间

- 53:48 复盘最近的硅谷求职记

- 53:54 Post-train 人才极其抢手

- 54:27 印象最深的是,面 Cursor 的时候,我甚至被允许用 Cursor 现场解题

- 56:03 最喜欢被问到「你觉得我们的 idea 有多不靠谱?」

- 56:45 如果我是面试官,我会考察面试者的这项直觉能力

- 57:28 我很喜欢现在硅谷的氛围!当下可能是华人扬眉吐气的最好时机

【活动预告🥳】

12 月 7 日,我们会请到 Ted 做一场线上活动,感兴趣的朋友欢迎点击链接或扫描下面的二维码,一起来认识&交流!

【The gang that made this happen】

- 制作人:陈皮、Celia

- 剪辑:陈皮

- Bgm:Mondo Bongo - Joe Strummer & The Mescaleros

评价...

空空如也

小宇宙热门评论...

苏西不是羊

1年前

北京

60

好像听了一场满分的面试👍

Joes东

1年前

广东

28

这期质量太高了 从头到尾没有一句废话 比那些嘻嘻哈哈的节目强太多👍

LearnWise

1年前

安徽

19

32:01 DPO 的过程中模型就是看一大批好的答案和不好的答案,类似于学生只看题目和答案,并不会自己做题目。RLHF 是模型会要做题目给出答案,然后奖励模型反馈这个答案好还是不好,类似于学生做题,老师批改。这两个的对比很像一句诗,纸上得来终觉浅,绝知此事要躬行。

FeedingHanni

1年前

新西兰

14

猴子老师…猴子老师…谢谢你,无论如何…谢谢你,你无论做什么都会成功的,猴子老师,猴子老师世界上有你了不起,你是大善人

FrankieYao

1年前

上海

6

听到最后一句话的时候,有点莫名的感动,谢谢曲凯,谢谢 Ted

domi_yVbI

1年前

上海

5

最后一句好感人

JASting

1年前

北京

4

21:29 模型的不可控要用更高频次的测试去迭代,迭代过程中每个人会去迭代不同的方向。 ——任何不可控的事情都是一样。

产品二姐

1年前

北京

4

推理大有可为

HD271259z

1年前

广东

4

一个产品好不好,听创造产品的人讲话就知道了😁超喜欢感谢创造cai的大家

YeNight

1年前

四川

4

最近c.ai超火,包括但不限于ai心理咨询推荐、ai练口语推荐,这一期太巧啦,火速来听

Nebula233

1年前

广东

3

为了听猴老师的访谈所以下载注册了这个软件🧐

kiaki宸

8个月前

湖北

2

也在做相关领域的工作,完整把播客听了两遍,很有启发!下面写一些我的零散的笔记:

SFT(监督微调) :和预训练差不多,但是数据对话质量更高,让模型看大量文字,文字接龙的矩阵;AB的话拼起来喂给模型

RLHF(人类反馈强化学习):对话无正解,有喜好的判断(开放式领域),有不同的答案,建立高效的奖励模型,判断哪一个答案更符合预期,强化模型(大量语料),拿用户反馈数据指导质量分类过程(数据的高质量)

DPO (直接偏好对齐):训练模型+参考模型,简单快速根据用户偏好堆(优质),建立反馈循环

评估:

理想:模拟人类用户偏好做打分意图识别,ab,严格回答还是轻松愉悦的回答,时间点+上下文,偏好对齐,看了之后知道怎么让用户喜欢

语音模型3个

很多公司: 某句话分成几个部分说出来

ASR:判断,转成文字,有没有说完

语言模型:输出话

tts:还原成语音

存到互联网,延迟相加1-2s,一个字一个字同步,0.5s

多模型混合,最好的模型判断意图

用不同的路由负责不同的模型,不同的场景

偏产品的公司专注在多模态,偏算法的公司在研究O1,两边态着眼于交互式的ai agent

做多模态,赚钱,商业模式 可能会选一种模态

产品+算法(数据怎么追)

Post train 人才稀缺,会说人话的模型--用户喜欢的模型

面试:对paper的美感的感知

汤布院

1年前

河南

2

猴子老师超绝气泡音哈哈

AsherYuu

1年前

北京

2

讲的很细致了,数据方面可以说是讲了很多被忽视和扭曲的常识

钟镇杰

1年前

广东

2

我靠,最后一句直接起鸡皮疙瘩

孙马特

1年前

北京

2

44:34 这个位置提到的可以减少延迟的技术是哪两个单词来着(? 实在是没有查到了

HD910522m

4个月前

湖北

1

复制,留痕

也在做相关领域的工作,完整把播客听了两遍,很有启发!下面写一些我的零散的笔记:

SFT(监督微调) :和预训练差不多,但是数据对话质量更高,让模型看大量文字,文字接龙的矩阵;AB的话拼起来喂给模型

RLHF(人类反馈强化学习):对话无正解,有喜好的判断(开放式领域),有不同的答案,建立高效的奖励模型,判断哪一个答案更符合预期,强化模型(大量语料),拿用户反馈数据指导质量分类过程(数据的高质量)

DPO (直接偏好对齐):训练模型+参考模型,简单快速根据用户偏好堆(优质),建立反馈循环

评估:

理想:模拟人类用户偏好做打分意图识别,ab,严格回答还是轻松愉悦的回答,时间点+上下文,偏好对齐,看了之后知道怎么让用户喜欢

语音模型3个

很多公司: 某句话分成几个部分说出来

ASR:判断,转成文字,有没有说完

语言模型:输出话

tts:还原成语音

存到互联网,延迟相加1-2s,一个字一个字同步,0.5s

多模型混合,最好的模型判断意图

用不同的路由负责不同的模型,不同的场景

偏产品的公司专注在多模态,偏算法的公司在研究O1,两边态着眼于交互式的ai agent

做多模态,赚钱,商业模式 可能会选一种模态

产品+算法(数据怎么追)

Post train 人才稀缺,会说人话的模型--用户喜欢的模型

面试:对paper的美感的感知

第865号剑客

1年前

上海

1

周五还是周六啊,写的12月7号(周五),但是7号是周六啊

一滴水_

1年前

浙江

1

嘉宾好猛!我有一个问题,嘉宾的回答是真的很快,还是说剪掉了一些思考过程,这“首token延迟”也太低了😂

猫Sir充电中

1年前

北京

1

请教主播和嘉宾,美国的产品经理是怎么做数据洞察的,有没有什么地方可以了解学习