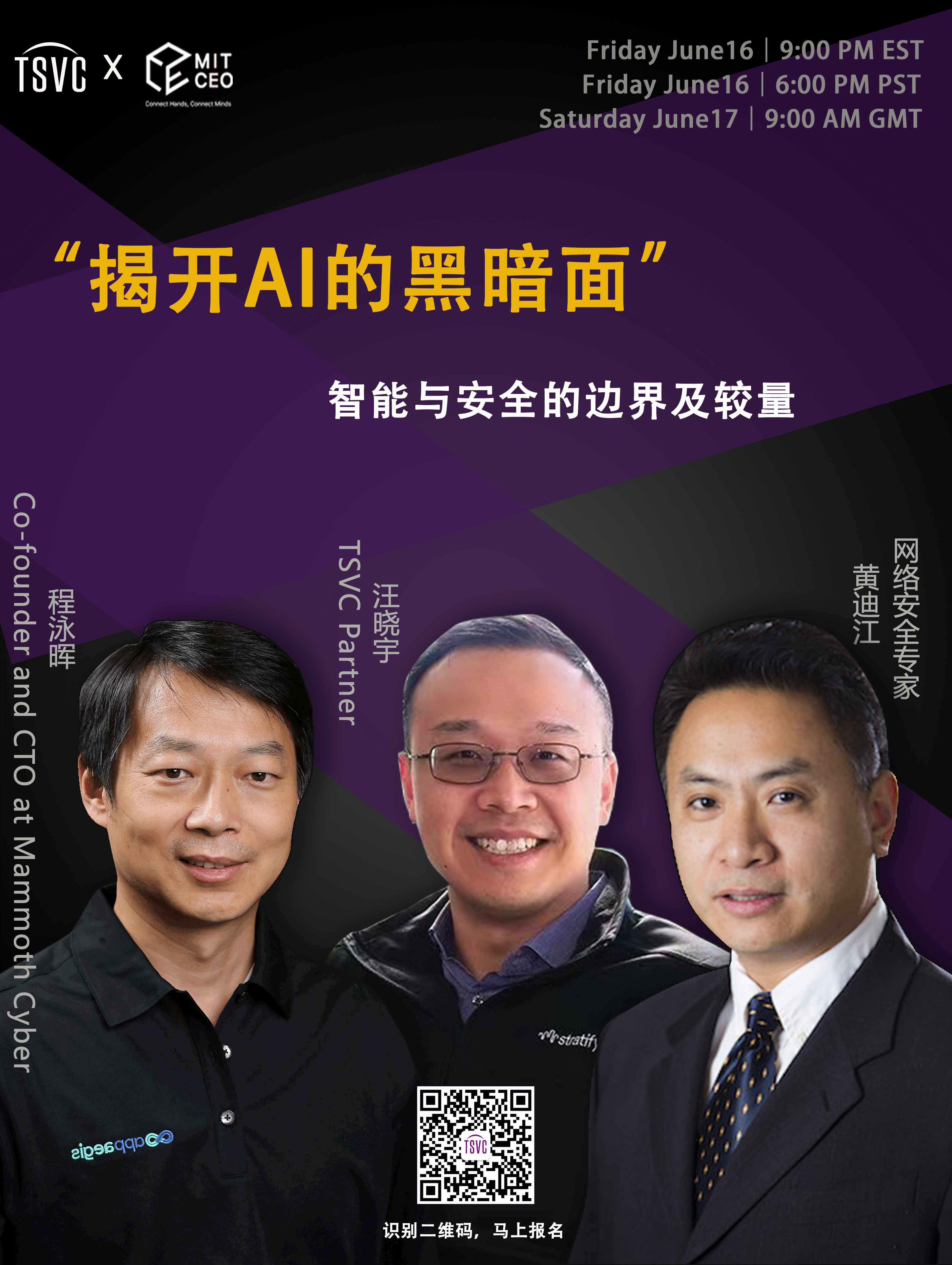

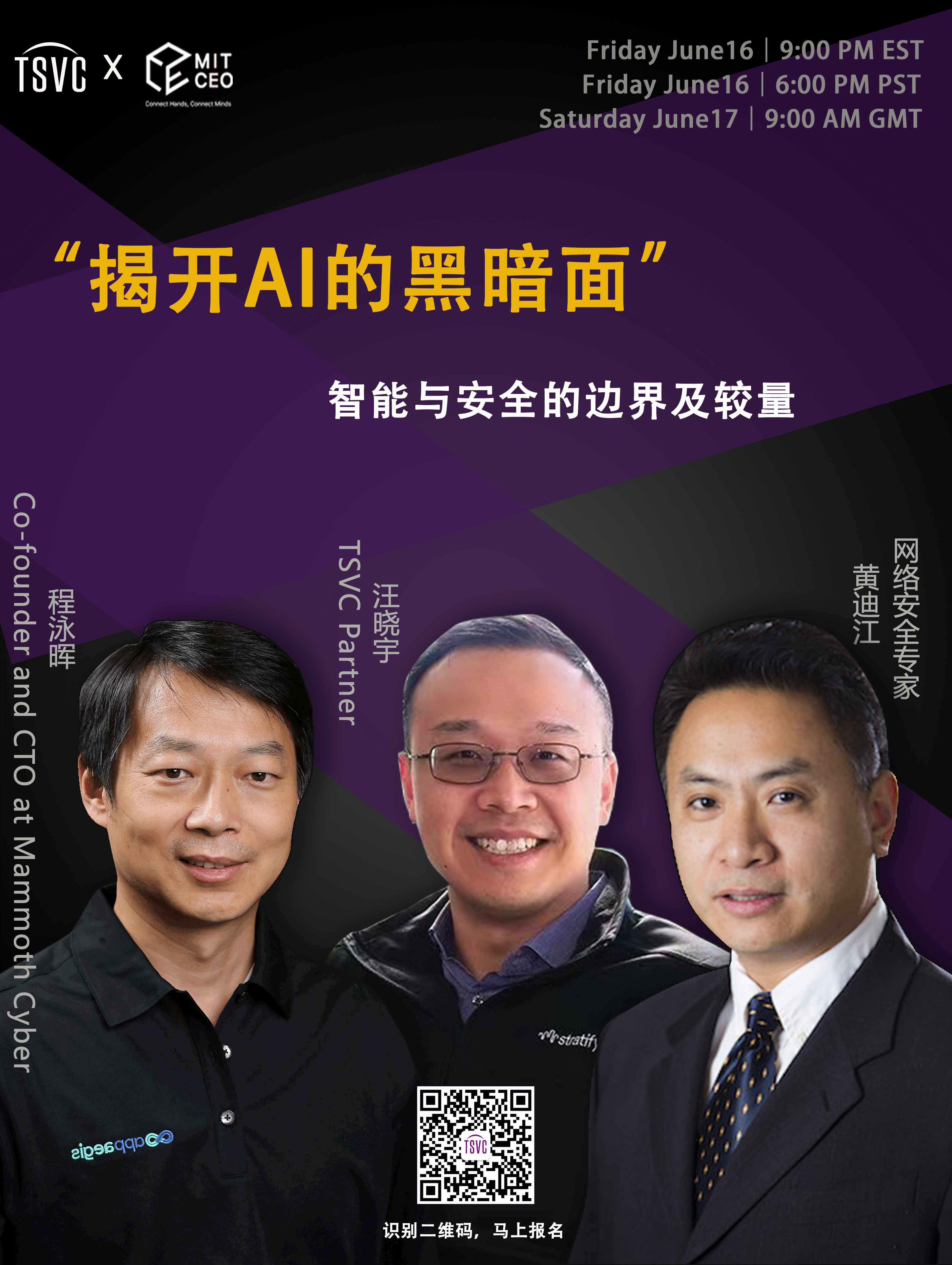

TSVC举办了《打造下一个独角兽》讲座十八讲,AI的可解释性、偏见、不实信息、隐私问题、和可靠性问题依旧困扰着行业;利用AI诈骗的案件层出不穷;AI对人类社会的工作生活方方面面的影响也才刚刚开始显现。面对AI的种种机遇和挑战,我们何去何从?TSVC和MIT CEO有幸邀请到TSVC合伙人、Stratifyd.Inc创始人Derek Wang博士、网络安全专家和前亚利桑那州立大学副教授黄迪江博士、和Mammoth Cyber联合创始人、首席技术官程泳晖先生,来与我们分享和探讨。

嘉宾:

汪晓宇,Dr. Derek Wang,TSVC Partner

黄迪江,Dr. Dijiang Huang,网络安全专家

程泳晖,Yonghui Cheng,Co-founder and CTO at Mammoth Cyber

我们都聊了什么

00:00 活动概要

01:05 活动主办方介绍

04:42 AI Security主要在解决什么问题,大概有哪些主要的研究方向?

10:53 AI privacy 要解决什么问题,都有哪些技术以及前沿的研究?

18:41 现在AI的大模型应用普及,它会给我们带来什么新的挑战?包括对于你们公司现在的安全产品提出了什么新的要求?

22:48 隐私在长期会如何影响到大模型的落地商用?

28:56 很多企业里面,大家都不知道数据是什么,比如说数据的名字、标注都没有做好,之前可能大家没有特别有兴趣去做这个事情。那现在是不是会有更多的动力,包括这块其实有很多企业是不是会得到更好的关注?

32:19 合成数据可以解决25年的数据缺失问题吗?

34:44 回到行业应用从外维度来讲,包括医疗金融这些领域,他们有很多自己行业非常好的数据,包括有很多doorman knowledge,他们可能没有大厂,包括OpenAI这种技术算力,嘉宾们觉得这两个方面之后会是什么样的关系?包括现在有很多大模型私有部署的创业企业,从这些角度来讲想听听大家看法。

40:40 刚才一开始嘉宾也介绍了一下偏见这方面的内容,其实就在之前ML就是一个长期的话题。包括美国有很多研究,当时是说用machine learning的模型去派遣警力,包括去做一些医疗教育的决策,当时讨论说会有一些公平方面的社会问题。那么从大语言模型来讲,嘉宾觉得跟传统的ML的偏见有什么不同?

48:06 最近其实有很多尝试,包括用GPT4来解释GPT2,有思维链turn of tree,希望大家能看到LLM的推理逻辑,大家怎么看这块儿是不是足够?还有哪些可解释性的问题待解决?

58:31 我们之前聊了很多数据层面,那么从训练层面,有人讲说要限制训练的能源,限制电力,包括模型层面,Sam Altman 提出说要限制ikvvt的模型,可能限制比如超过多少参数量的模型,或者是限制模型的产出,包括是不是从API这几个方面限制,大家有什么想分享一下?

1:06:00 说到创业,在这方面会有别的什么创业机会?最开始黄老师提到可能在芯片上会有一些新的机会。

1:10:04 这个大模型或者AI到底有没有自己意识?他会不会独立于人类,甚至跟人类做一个一对。

提到的公司/项目

• AI Security

• 隐私和安全

• LLM

• 生成合成数据

• 机密计算

• chatGPT

• DLP(数据泄露防护)

• AGI

• CrowdStrike

• Charlotte人工智能系统

• LLaMA

• 大型语言模型技术LLM

• LLaMa.cpp

• health care的company

• BCBS Blue Shield Blue Cross

• Self-Instruct模型

• ML

• Alpha Go

• Nvidia

AI Security主要在解决什么问题,大概有哪些主要的研究方向?

就AI Security而言,TSVC Partner,Derek Wang表示他可能也是一个从应用层面往里面去看的这样一个学术。Security主要解决问题,他想从三个层面来讲解。首先是个人层面,任何一个个人层面来讲,AI Security上很大的一个挑战是隐私,包括个人隐私和它对数据收取的一个过程。这种隐私和风险对个人层面带来的影响可以直接涉及到种族歧视等问题,并且可能会导致个人信息受到极度的暴露,创造了许多钻空子的机会,例如窃取个人信息来进行欺诈等。随着大语言模型等技术的出现,这种网络信息欺诈行为会变得更加多样化,这些都是通过AI技术对个人层面安全进行攻击的一个过程。

其次是公司层面,同时也是TSVC基金看的一个方向。现在主要的大型企业和创业公司所关注的不仅是个人隐私层面的保护,而是对个人隐私做出提升。从群体的角度来看,像很多大银行,每个部门大约有1000个AI模型。在这个层面上,企业对于AI模型本身的数据丢失保护,即模型的数据不想被其他人知道,因为这些数据是企业内部的数据。但是现在,越来越多的攻击手段正在应用于数据窃取,这将直接将企业数据带走。这就成为一个很大的问题。对于企业而言,数据的积累包括模型训练是一个非常重要的过程,无论模型是开源还是闭源,企业的数据与模型可能都会成为攻击的目标。对于企业级别而言,实际上存在一种攻击方式,即攻击者通过破解手段绕过模型的安全措施打开模型。这种攻击方式会使得模型的算法和数据被第三方获取。在企业成绩上,这种流失知识产权和内部数据的情况会导致更多的信任和安全问题。而且,随着LLM的出现,恶意代码放入模型中的情况也越来越多。

最后,这个层面是比较大的,就是政府层面,政府层面就有更大的社会影响力。比如他跟Dr. Wenwen Dou(UNCC) 正在从事虚假信息和误导信息的研究。在这个领域,对于政府来说,它最害怕的是使用大语言模型技术,可以制作虚拟视频和声音,将知名政治人物如拜登或特朗普的形象放在其中,并通过技术手段操纵其表现和言论。这种技术很容易被用于制造虚假信息和误导信息,给公众带来深远的影响。尤其是在2024年选举期间,这种情况可能会更加严重。Derek表示,他今早看到一些新闻,大约1.5亿美元的资金可能被用于制造虚假信息和误导信息。AI Security其实更多的是用于防范不法分子的这么一个前提。

所以从TSVC基金的角度来看,AI安全领域有三个主要方向:如何保护个人信息、企业信息和模型数据的安全;最终是如何保护政府的,减少社会的媒体乱象。这三个大的方向,是TSVC基金正在看的一个角度。

AI privacy 要解决什么问题,都有哪些技术以及前沿的研究?

网络安全专家黄迪江博士认为,实际上隐私和安全是非常紧密相关。但在看待隐私计算时,人们常常将其与安全混淆,难以分清两者的具体区别。他提供了一个简单的方式来说明,隐私计算实际上解决的是隐私数据的保护问题,涉及到数据可信度的问题,即谁能访问和查看数据。在这个意义上,隐私计算和安全之间具备可行性上的类似之处,但隐私计算它的最终的被攻击的结果是和安全是有一些微微小的区别。

从安全的视角来看,攻击的结果可能会导致系统数据的暴露或不可用等直接后果。而隐私计算的结果则可能是通过一个间接的过程实现的,尤其是在数据暴露后,如果这些数据被恶意利用,它才会真正造成不良的影响。因此,通常情况下,一般用户在谈论隐私计算时很难区分隐私和安全两个方面之间的区别。

从技术角度来看,LLM的隐私可以分为两个阶段。第一个阶段是数据训练阶段,在这个阶段,我们使用什么样的数据非常重要。通常来说,这个阶段包含几个步骤。其中第一步是数据源步骤,我们可以使用掩码技术对数据进行隐藏,以隐藏一些重要的关键信息。在这个阶段,我们可以自然地去除一些敏感信息。

还有可以通过生成合成数据等方案,比如说通过对抗网络,可以根据现有的数据生成一些合成数据,它的训练结果可能和真实数据训练结果也是类似的。在训练过程中,可以通过模糊化数据信息,人为地加入噪音等方式来较好地保护数据的隐私。这样的做法可能会导致模型训练结果不够准确,可能会有一定的误差。在某些应用场景中,这种方法会影响用户体验。例如,在使用手机自动联想输入法等功能时,由于加入了差分隐私的方式,使用模糊输入推荐的准确度可能会下降,和几年前没有加入这个差分隐私的这种方式,实际上用户体验差了很多。

在隐私计算领域,还有一些传统的技术方案可以实现数据安全和隐私保护。比如,最近联合国专门发布了隐私计算的一些相对来说正常技术,可以分为三个方面。首先,基于算法方面的技术,比如多方安全计算和加密等技术,是通过算法的方式来实现数据安全和隐私保护的。通过运用这些技术,单方或多方能够计算出结果,同时而不暴露数据本身的内容是通过这个算法方式来实现。其次,通过体系结构方面的技术,比如联邦计算等技术,可以将数据分为多份或切分模型,以一个可信方对数据参数汇总分发、从而对数据源进行保护。这种方式使得多方能够对数据安全地进行计算,确保了数据隐私的保护。

那么另一种方式的话是通过机密计算,机密计算是一种通过硬件实现数据隐私保护的方式。你可以创建一个可信域,你对数据进行实际的操作,在这种方式下,可信域和不可信域被划分出来,而操作只会在可信域内进行,这可以确保数据的安全性。但实际上,机密计算在实际场景中还存在信任性的问题,如果无法解决这个问题,那么无论使用什么技术,最终都会存在优缺点。我们可以看到实际上基于机密计算的效率相对是比较高的。而基于算法类的方式的话,实际上它的性能各方面有很大的制约,所以在进行数据训练的时候,使用多方计算等方式,实际上效率是非常低的,尤其是在大模型训练下的话,可能会造成一些问题。

另一个阶段就是使用阶段。使用阶段如果模型建立了以后,有没有办法在模型使用的时候,对用户的进行一些保护,比如可以采用多方计算、同态加密等方式来对用户的查询信息进行保护,同时在数据生成阶段,也可以通过filter等方式去除敏感信息,从而实现数据隐私保护。然而,即使使用了这些保护措施,还是可能会出现一些漏网之鱼,因为隐私计算本身也是一个非常非常复杂的这个领域。

现在AI的大模型应用普及,它会给我们带来什么新的挑战?包括对于你们公司现在的安全产品提出了什么新的要求?

Appaegis Inc联合创始人程泳晖先生表示,这的确是一个全新的挑战。那他们公司做的产品主要是为了方便员工远程办公,无论是在家还是混合办公场所,他们都可以通过该公司的软件远程访问内部数据或应用。但是最近很多客户都在问,如何允许员工使用chatGPT,但又担心员工会将公司内部文件或数据外泄。能不能提供数据扫描和监控服务,以保证用户数据的安全性。那就是说他们也是在看这方面的需求。

有些公司可能会采用简单粗暴的方法,比如限制访问某些网站来保护网络安全,但这种方法并不一定有效。即使你在公司的计算机上不能访问某些网站,但是员工还是可以在他们的手机或其他电脑上访问,甚至经过我们系统去给它过滤的话,也是能够过滤一部分,但是我们也不可能说在所有的情况下都可以去扫描,因为有的时候他也是用个人的计算机去访问,这是企业用户最关心的问题,从网络安全角度,这是DLP(数据泄露防护)这方面的内容。

因字数限制,更多内容请收听音频

欢迎关注“TSVC”的微信公众号,了解更多早期创投相关话题的干货内容!

加入日常交流群请看海报,添加TSVC小助手

空空如也

暂无小宇宙热门评论