时长:

103分钟

播放:

1.95万

发布:

3个月前

主播...

简介...

今天这集节目,我们将讨论一个在当下非常关键的话题:人工智能的算法与架构创新。

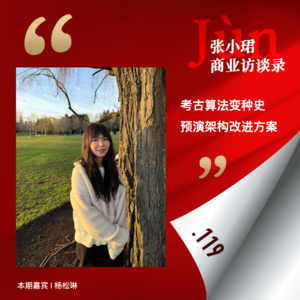

嘉宾是我们的往期嘉宾返场,她是MIT在读博士杨松琳,研究方向是线性注意力机制。

我们将从最新发布的几个模型Kimi Linear、Minimax M2、Qwen3-Next切入。松琳参与讨论Kimi Linear和Qwen3-Next的部分工作,是Kimi Linear论文的作者之一。

算法创新为什么在2025年变得尤为重要?

它的背后原因是,数据、算力和算法是驱动人工智能的三驾火车,在数据撞墙的无奈前提下,各个模型公司不得不重新开始“雕模型架构”,以期Scaling Law的魔法继续。而由于中国的算力相对美国有限,这反而让中国的AI算法创新走在了世界前沿。

这集节目你将听到,近几年架构最大突破是DeepSeek的MoE(混合专家模型),它让MoE成为了全球共识;而下一个突破的重要方向可能就是Attention(注意力机制)。

中国公司在Attention展开了不同技术bet(押注):

* 截至目前已发布模型,DeepSeek正在探索Sparse Attention(稀疏注意力机制);

* Kimi正在探索Linear Attention(线性注意力机制);

* Minimax在年初的M1版本中探索Linear Attention,而在刚发布的M2版本中又回退到 Full Attention(全局注意力机制)。

节目中,松琳将讲解她参与的这篇《Kimi Linear: An Expressive, Efficient Attention Architecture》的工作,并分析以上这些公司在Attention上的不同抉择;

与此同时,她也将带领大家考古人工智能算法变种史,并预演未来算法与架构的改进方案。

本集比较硬核,会有一些专业难度,大家可以根据自己的实际需要收听嗷:)因为嘉宾的工作环境会出现中英夹杂,希望大家多多理解和支持。

04:00 个人、研究主线与线性注意力机制的探索之路

06:27 松琳做过一个开源库:flash-linear-attention(简称FLA)

07:04 怎么通俗理解Linear Attention的Linear?

11:19 聊聊最近参与的新工作,前几天刚发布的《Kimi Linear: An Expressive, Efficient Attention Architecture》(Kimi Linear:一种具有强表达能力与高效率的注意力架构)

(FLA库的另一个作者Zhang, Yu邀请)

12:20 为什么Kimi在年初开始需要重新设计注意力机制?设计的背景和目标

在Linear Attention下,推理阶段的计算与显存成本都显著降低;而使用Full Attention时,长文本解码的代价会非常高昂

14:39 《Kimi Linear》论文重点讲解:KDA模块(Kimi Delta Attention,增量注意力机制)

18:56 Kimi内部有一个Scaling Ladder(规模阶梯),在一个规模下面表现好就在下一个规模下面去scale,就像通关

20:20 Kimi Linear Attention vs DeepSeek Sparse Attention:Kimi走线性注意力路线,DeepSeek走稀疏注意力路线,都想解决长文本decoding(长上下文生成)的效率问题

23:01 Minimax从M1到M2的架构变化,从Linear Attention退回到Full Attention,为什么?

27:00 硅谷的注意力机制方案不方便说,但可以浅聊一下OpenAI有paper的方案

28:05 Linear Attention从2020年发明出来开始后的前进线索

每一次大家关心Linear Attention都是因为大家撞到了Context Wall

最近长文本的decoding卷土重来,让人们不由自主审视这一套技术

38:16 纯Linear Attention是无效的,混合注意力机制还是有很多全局注意力层,这样下限有保证

40:30 Kimi Linear每3层KDA插入1层全注意力层,三比一的比例快变成共识了

Minimax之前用的是七比一,但现在大家逐渐回到三比一——这成为不共识的混合注意力机制中的共识了

42:32 权衡(Trade-off)表达能力(expressivity)与计算效率(efficiency)

Minimax曾经也提到,混合线性注意力/混合滑窗注意力在“多跳推理”上会有缺陷

对于“多跳推理”,如果我们开发一些硬件高效但表达能力更好的RNN(循环神经网络),这个GAP有可能缩小

46:28 chunkwise algorithm for parallelization(分块并行算法)

47:55 如何设计Attention?两条主流和一些非主流路线

49:36 结合Linear Attention和Sparse Attention的未来理想方案

Linear Attention和Sparse Attention没什么竞争关系,Linear Attention的竞争对手可能是Sliding-Window Attention(滑窗注意力)

工业界Linear Attention和Sparse Attention结合的探索似乎还没开始

我想象中的理想方案是:把混合注意力的全局注意力(Full Attention)换成稀疏注意力(Sparse Attention)

只要Sparse Attention选得准,完全可以取代Full Attention,但现在的问题是它选不准

55:36 公平的比较:Linear Attention vs Sliding-Window Attention(滑窗注意力)

57:05 Transformer → MoE → Linear/Sparse Attention的算法演变,背后动因是给定你相同的FLOPs(浮点运算量),利用这些FLOPs,取得更低的损失函数

MoE(混合专家)是更高效的FNN(前馈神经网络)的替代品

58:26 近几年架构方面突破最大的是MoE,下一个突破可能是Attention;Transformer就两个模块,一个是FFN,一个是Attention;现在FFN已经雕成MoE,现在Attention大家也可以雕一下

01:01:28 数据、算法、算力是驱动人工智能的三驾马车,当数据遇到数据强,算法创新变得更重要

01:02:48 架构的未来:1、能不能干掉全局注意力?它是阻止context window继续scale up的主要瓶颈

2、Continue Learning,让AI自己学习

01:04:30 如何把Linear Attention的Transformer继续scale up?

01:07:43 中国AI的算法创新相比海外肯定是更强的——因为没有那么多卡(

不过美国公司更多投入优化器一点,国内在逐步重视

01:10:56 其他训练细节:NoPE vs. RoPE

01:12:09 DeepSeek-OCR

01:12:55 松琳也参与了Qwen3-Next,没有参与Minimax M2

01:13:39 “雕”架构的人

01:15:16 自己的心路:“当你很清楚你要做什么的时候,你是不会遇到什么挫折的”

经验分享:PhD还挺顺利的,得益于我入学之前的半年考古

01:23:12 说到考古,我们在最后聊聊从Transformer开始的算法变种历史

01:29:50 Delta Rule算法、硬件亲和、DeepSeek非常追求硬件和算法的匹配

01:42:23 给更年轻的年轻人的建议

嘉宾往期节目:

《逐篇讲解DeepSeek、Kimi、MiniMax注意力机制新论文——“硬件上的暴力美学”》

谈到的论文:

《Kimi Linear: An Expressive, Efficient Attention Architecture》

《MiniMax-M1: Scaling Test-Time Compute Efficiently with Lightning Attention》

《DeepSeekMoE: Towards Ultimate Expert Specialization in Mixture-of-Experts Language Models》

嘉宾是我们的往期嘉宾返场,她是MIT在读博士杨松琳,研究方向是线性注意力机制。

我们将从最新发布的几个模型Kimi Linear、Minimax M2、Qwen3-Next切入。松琳参与讨论Kimi Linear和Qwen3-Next的部分工作,是Kimi Linear论文的作者之一。

算法创新为什么在2025年变得尤为重要?

它的背后原因是,数据、算力和算法是驱动人工智能的三驾火车,在数据撞墙的无奈前提下,各个模型公司不得不重新开始“雕模型架构”,以期Scaling Law的魔法继续。而由于中国的算力相对美国有限,这反而让中国的AI算法创新走在了世界前沿。

这集节目你将听到,近几年架构最大突破是DeepSeek的MoE(混合专家模型),它让MoE成为了全球共识;而下一个突破的重要方向可能就是Attention(注意力机制)。

中国公司在Attention展开了不同技术bet(押注):

* 截至目前已发布模型,DeepSeek正在探索Sparse Attention(稀疏注意力机制);

* Kimi正在探索Linear Attention(线性注意力机制);

* Minimax在年初的M1版本中探索Linear Attention,而在刚发布的M2版本中又回退到 Full Attention(全局注意力机制)。

节目中,松琳将讲解她参与的这篇《Kimi Linear: An Expressive, Efficient Attention Architecture》的工作,并分析以上这些公司在Attention上的不同抉择;

与此同时,她也将带领大家考古人工智能算法变种史,并预演未来算法与架构的改进方案。

本集比较硬核,会有一些专业难度,大家可以根据自己的实际需要收听嗷:)因为嘉宾的工作环境会出现中英夹杂,希望大家多多理解和支持。

04:00 个人、研究主线与线性注意力机制的探索之路

06:27 松琳做过一个开源库:flash-linear-attention(简称FLA)

07:04 怎么通俗理解Linear Attention的Linear?

11:19 聊聊最近参与的新工作,前几天刚发布的《Kimi Linear: An Expressive, Efficient Attention Architecture》(Kimi Linear:一种具有强表达能力与高效率的注意力架构)

(FLA库的另一个作者Zhang, Yu邀请)

12:20 为什么Kimi在年初开始需要重新设计注意力机制?设计的背景和目标

在Linear Attention下,推理阶段的计算与显存成本都显著降低;而使用Full Attention时,长文本解码的代价会非常高昂

14:39 《Kimi Linear》论文重点讲解:KDA模块(Kimi Delta Attention,增量注意力机制)

18:56 Kimi内部有一个Scaling Ladder(规模阶梯),在一个规模下面表现好就在下一个规模下面去scale,就像通关

20:20 Kimi Linear Attention vs DeepSeek Sparse Attention:Kimi走线性注意力路线,DeepSeek走稀疏注意力路线,都想解决长文本decoding(长上下文生成)的效率问题

23:01 Minimax从M1到M2的架构变化,从Linear Attention退回到Full Attention,为什么?

27:00 硅谷的注意力机制方案不方便说,但可以浅聊一下OpenAI有paper的方案

28:05 Linear Attention从2020年发明出来开始后的前进线索

每一次大家关心Linear Attention都是因为大家撞到了Context Wall

最近长文本的decoding卷土重来,让人们不由自主审视这一套技术

38:16 纯Linear Attention是无效的,混合注意力机制还是有很多全局注意力层,这样下限有保证

40:30 Kimi Linear每3层KDA插入1层全注意力层,三比一的比例快变成共识了

Minimax之前用的是七比一,但现在大家逐渐回到三比一——这成为不共识的混合注意力机制中的共识了

42:32 权衡(Trade-off)表达能力(expressivity)与计算效率(efficiency)

Minimax曾经也提到,混合线性注意力/混合滑窗注意力在“多跳推理”上会有缺陷

对于“多跳推理”,如果我们开发一些硬件高效但表达能力更好的RNN(循环神经网络),这个GAP有可能缩小

46:28 chunkwise algorithm for parallelization(分块并行算法)

47:55 如何设计Attention?两条主流和一些非主流路线

49:36 结合Linear Attention和Sparse Attention的未来理想方案

Linear Attention和Sparse Attention没什么竞争关系,Linear Attention的竞争对手可能是Sliding-Window Attention(滑窗注意力)

工业界Linear Attention和Sparse Attention结合的探索似乎还没开始

我想象中的理想方案是:把混合注意力的全局注意力(Full Attention)换成稀疏注意力(Sparse Attention)

只要Sparse Attention选得准,完全可以取代Full Attention,但现在的问题是它选不准

55:36 公平的比较:Linear Attention vs Sliding-Window Attention(滑窗注意力)

57:05 Transformer → MoE → Linear/Sparse Attention的算法演变,背后动因是给定你相同的FLOPs(浮点运算量),利用这些FLOPs,取得更低的损失函数

MoE(混合专家)是更高效的FNN(前馈神经网络)的替代品

58:26 近几年架构方面突破最大的是MoE,下一个突破可能是Attention;Transformer就两个模块,一个是FFN,一个是Attention;现在FFN已经雕成MoE,现在Attention大家也可以雕一下

01:01:28 数据、算法、算力是驱动人工智能的三驾马车,当数据遇到数据强,算法创新变得更重要

01:02:48 架构的未来:1、能不能干掉全局注意力?它是阻止context window继续scale up的主要瓶颈

2、Continue Learning,让AI自己学习

01:04:30 如何把Linear Attention的Transformer继续scale up?

01:07:43 中国AI的算法创新相比海外肯定是更强的——因为没有那么多卡(

不过美国公司更多投入优化器一点,国内在逐步重视

01:10:56 其他训练细节:NoPE vs. RoPE

01:12:09 DeepSeek-OCR

01:12:55 松琳也参与了Qwen3-Next,没有参与Minimax M2

01:13:39 “雕”架构的人

01:15:16 自己的心路:“当你很清楚你要做什么的时候,你是不会遇到什么挫折的”

经验分享:PhD还挺顺利的,得益于我入学之前的半年考古

01:23:12 说到考古,我们在最后聊聊从Transformer开始的算法变种历史

01:29:50 Delta Rule算法、硬件亲和、DeepSeek非常追求硬件和算法的匹配

01:42:23 给更年轻的年轻人的建议

嘉宾往期节目:

《逐篇讲解DeepSeek、Kimi、MiniMax注意力机制新论文——“硬件上的暴力美学”》

谈到的论文:

《Kimi Linear: An Expressive, Efficient Attention Architecture》

《MiniMax-M1: Scaling Test-Time Compute Efficiently with Lightning Attention》

《DeepSeekMoE: Towards Ultimate Expert Specialization in Mixture-of-Experts Language Models》

评价...

空空如也

小宇宙热门评论...

CAD_6zrr

3个月前

美国

33

希望有更多这样采访研究员的hardcore内容!

CAD_6zrr

3个月前

美国

32

希望有更多这样采访研究员的hardcore内容!

CAD_6zrr

3个月前

美国

30

希望有更多这样采访研究员的hardcore内容!

CAD_6zrr

3个月前

美国

24

希望有更多这样采访研究员的hardcore内容!

CAD_6zrr

3个月前

美国

22

希望有更多这样采访研究员的hardcore内容!

HD207590e

3个月前

浙江

15

下一期请bo来对线hhh

HD207590e

3个月前

浙江

15

下一期请bo来对线hhh

HD207590e

3个月前

浙江

15

下一期请bo来对线hhh

HD207590e

3个月前

浙江

14

下一期请bo来对线hhh

HD207590e

3个月前

浙江

12

下一期请bo来对线hhh

Raymond_Tsao

3个月前

北京

11

最近有本书智能简史max benett写的,里面讲到人类大脑的功能和结构研究,介绍了很多前沿进展,对AI的架构设计绝对有借鉴意义。

Raymond_Tsao

3个月前

北京

11

最近有本书智能简史max benett写的,里面讲到人类大脑的功能和结构研究,介绍了很多前沿进展,对AI的架构设计绝对有借鉴意义。

Raymond_Tsao

3个月前

北京

10

最近有本书智能简史max benett写的,里面讲到人类大脑的功能和结构研究,介绍了很多前沿进展,对AI的架构设计绝对有借鉴意义。

莓莓Joy

3个月前

北京

8

是Sonta🥳!

莓莓Joy

3个月前

北京

8

是Sonta🥳!

莓莓Joy

3个月前

北京

8

是Sonta🥳!

莓莓Joy

3个月前

北京

8

是Sonta🥳!

莓莓Joy

3个月前

北京

8

是Sonta🥳!

Puster_Lee

3个月前

北京

7

02:48 MOE怎么成DS发明的了?

Raymond_Tsao

3个月前

北京

7

最近有本书智能简史max benett写的,里面讲到人类大脑的功能和结构研究,介绍了很多前沿进展,对AI的架构设计绝对有借鉴意义。

Puster_Lee

3个月前

北京

6

02:48 MOE怎么成DS发明的了?

Puster_Lee

3个月前

北京

6

02:48 MOE怎么成DS发明的了?

Puster_Lee

3个月前

北京

6

02:48 MOE怎么成DS发明的了?

Puster_Lee

3个月前

北京

6

02:48 MOE怎么成DS发明的了?

Raymond_Tsao

3个月前

北京

6

最近有本书智能简史max benett写的,里面讲到人类大脑的功能和结构研究,介绍了很多前沿进展,对AI的架构设计绝对有借鉴意义。

五里坨

3个月前

北京

5

下期要是Bo的话效果拉满

五里坨

3个月前

北京

5

下期要是Bo的话效果拉满

五里坨

3个月前

北京

5

下期要是Bo的话效果拉满

五里坨

3个月前

北京

5

下期要是Bo的话效果拉满

五里坨

3个月前

北京

5

下期要是Bo的话效果拉满

生而为猫奴

3个月前

未知

4

1:26:51 有实力,就是这么自信👍👍

张小珺

2个月前

英国

4

知道大家想👀文字版,我们刚发出来啦(搜索公众号:语言即世界language is world):https://mp.weixin.qq.com/s/USj6wbOI8CD0MTQCQ01hXQ

生而为猫奴

3个月前

未知

4

1:26:51 有实力,就是这么自信👍👍

张小珺

2个月前

英国

4

知道大家想👀文字版,我们刚发出来啦(搜索公众号:语言即世界language is world):https://mp.weixin.qq.com/s/USj6wbOI8CD0MTQCQ01hXQ

生而为猫奴

3个月前

未知

4

1:26:51 有实力,就是这么自信👍👍

张小珺

2个月前

英国

4

知道大家想👀文字版,我们刚发出来啦(搜索公众号:语言即世界language is world):https://mp.weixin.qq.com/s/USj6wbOI8CD0MTQCQ01hXQ

生而为猫奴

3个月前

未知

4

1:26:51 有实力,就是这么自信👍👍

生而为猫奴

3个月前

未知

4

1:26:51 有实力,就是这么自信👍👍

祖春山

3个月前

北京

3

等到了,很及时!

HD23404u

3个月前

广东

3

kimi linear不是更像rwkv第7代了么?

fusion_chen

2个月前

广东

3

12:50 内容不错,不过听的太累了。主持人可以提醒嘉宾之后接受采访说中文的时候不要一直用“然后,然后”来连接下一句话吗?

祖春山

3个月前

北京

3

等到了,很及时!

HD23404u

3个月前

广东

3

kimi linear不是更像rwkv第7代了么?

fusion_chen

2个月前

广东

3

12:50 内容不错,不过听的太累了。主持人可以提醒嘉宾之后接受采访说中文的时候不要一直用“然后,然后”来连接下一句话吗?

祖春山

3个月前

北京

3

等到了,很及时!

HD23404u

3个月前

广东

3

kimi linear不是更像rwkv第7代了么?

fusion_chen

2个月前

广东

3

12:50 内容不错,不过听的太累了。主持人可以提醒嘉宾之后接受采访说中文的时候不要一直用“然后,然后”来连接下一句话吗?

祖春山

3个月前

北京

3

等到了,很及时!

HD23404u

3个月前

广东

3

kimi linear不是更像rwkv第7代了么?

张小珺

2个月前

英国

3

知道大家想👀文字版,我们刚发出来啦(搜索公众号:语言即世界language is world):https://mp.weixin.qq.com/s/USj6wbOI8CD0MTQCQ01hXQ

祖春山

3个月前

北京

3

等到了,很及时!

HD23404u

3个月前

广东

3

kimi linear不是更像rwkv第7代了么?

张小珺

2个月前

英国

3

知道大家想👀文字版,我们刚发出来啦(搜索公众号:语言即世界language is world):https://mp.weixin.qq.com/s/USj6wbOI8CD0MTQCQ01hXQ

HD134845z

3个月前

江苏

2

喜欢这期内容,喜欢这种相对硬核的分享

Chay__

3个月前

北京

2

作为AI infra和AI芯片从业人员听起来感觉很不错👍

Raymond_Tsao

3个月前

北京

2

这堂课有文本就好了,有些术语需要搜索理解

伊利丹怒风

2个月前

北京

2

这个小姐姐很敢说、而且观点都很有逻辑,非常棒,希望以后经常来。

AI时代

3个月前

福建

2

冒昧提个暴论,一般人理解这技术内幕意义不大,就像一般人使用iPhone手机并不需要去深挖IPhone操作系统底层原理

Chay__

3个月前

北京

2

作为AI infra和AI芯片从业人员听起来感觉很不错👍

Raymond_Tsao

3个月前

北京

2

这堂课有文本就好了,有些术语需要搜索理解

伊利丹怒风

2个月前

北京

2

这个小姐姐很敢说、而且观点都很有逻辑,非常棒,希望以后经常来。

AI时代

3个月前

福建

2

冒昧提个暴论,一般人理解这技术内幕意义不大,就像一般人使用iPhone手机并不需要去深挖IPhone操作系统底层原理

Chay__

3个月前

北京

2

作为AI infra和AI芯片从业人员听起来感觉很不错👍

Raymond_Tsao

3个月前

北京

2

这堂课有文本就好了,有些术语需要搜索理解

伊利丹怒风

2个月前

北京

2

这个小姐姐很敢说、而且观点都很有逻辑,非常棒,希望以后经常来。

AI时代

3个月前

福建

2

冒昧提个暴论,一般人理解这技术内幕意义不大,就像一般人使用iPhone手机并不需要去深挖IPhone操作系统底层原理

Raymond_Tsao

3个月前

北京

2

这堂课有文本就好了,有些术语需要搜索理解

Raymond_Tsao

3个月前

北京

2

这堂课有文本就好了,有些术语需要搜索理解

Niche_Dy9I

3个月前

北京

1

过于牛逼

巴黎的胖子

2个月前

北京

1

匠气太重

好几只小黄猫

2个月前

北京

1

我最喜欢这一期,希望这种真正有水平的技术访谈多一些

AIspire

2个月前

上海

1

一直在打脸mnimax的架构,哈哈哈,不知道他们听到了作何感想

章鲤

3个月前

浙江

1

这期门槛好高,大佬讲的好多都听不懂😂

Niche_Dy9I

3个月前

北京

1

过于牛逼

好几只小黄猫

2个月前

北京

1

我最喜欢这一期,希望这种真正有水平的技术访谈多一些

AIspire

2个月前

上海

1

一直在打脸mnimax的架构,哈哈哈,不知道他们听到了作何感想

章鲤

3个月前

浙江

1

这期门槛好高,大佬讲的好多都听不懂😂

Niche_Dy9I

3个月前

北京

1

过于牛逼

好几只小黄猫

2个月前

北京

1

我最喜欢这一期,希望这种真正有水平的技术访谈多一些

AIspire

2个月前

上海

1

一直在打脸mnimax的架构,哈哈哈,不知道他们听到了作何感想

HD134845z

3个月前

江苏

1

喜欢这期内容,喜欢这种相对硬核的分享

Chay__

3个月前

北京

1

作为AI infra和AI芯片从业人员听起来感觉很不错👍

章鲤

3个月前

浙江

1

这期门槛好高,大佬讲的好多都听不懂😂

Niche_Dy9I

3个月前

北京

1

过于牛逼

AIspire

2个月前

上海

1

一直在打脸mnimax的架构,哈哈哈,不知道他们听到了作何感想

伊利丹怒风

2个月前

北京

1

这个小姐姐很敢说、而且观点都很有逻辑,非常棒,希望以后经常来。

fusion_chen

2个月前

广东

1

12:50 内容不错,不过听的太累了。主持人可以提醒嘉宾之后接受采访说中文的时候不要一直用“然后,然后”来连接下一句话吗?

AI时代

3个月前

福建

1

冒昧提个暴论,一般人理解这技术内幕意义不大,就像一般人使用iPhone手机并不需要去深挖IPhone操作系统底层原理

HD134845z

3个月前

江苏

1

喜欢这期内容,喜欢这种相对硬核的分享

Chay__

3个月前

北京

1

作为AI infra和AI芯片从业人员听起来感觉很不错👍

章鲤

3个月前

浙江

1

这期门槛好高,大佬讲的好多都听不懂😂

Niche_Dy9I

3个月前

北京

1

过于牛逼

AI时代

3个月前

福建

1

冒昧提个暴论,一般人理解这技术内幕意义不大,就像一般人使用iPhone手机并不需要去深挖IPhone操作系统底层原理

西西莉亚呀

2个月前

北京

0

求文字稿

西西莉亚呀

2个月前

北京

0

求文字稿

好几只小黄猫

2个月前

北京

0

我最喜欢这一期,希望这种真正有水平的技术访谈多一些

巴黎的胖子

2个月前

北京

0

匠气太重

健_YR8t

2个月前

美国

0

感谢分享,请继续请研究员来

好几只小黄猫

2个月前

北京

0

我最喜欢这一期,希望这种真正有水平的技术访谈多一些

fusion_chen

2个月前

广东

0

12:50 内容不错,不过听的太累了。主持人可以提醒嘉宾之后接受采访说中文的时候不要一直用“然后,然后”来连接下一句话吗?