在 AIGC 持续突破视频生成边界的当下,音效制作仍是制约行业发展的瓶颈。字节跳动豆包大模型语音团队最新提出的 SeedFoley 模型,通过端到端架构实现了视频音效的智能生成,将 AI 视频创作带入「有声时代」。相关功能「AI 音效」已在即梦上线,用户使用即梦生成视频后,选择「AI 音效」功能,即可生成 3 个专业级音效方案。

App 端

Web 端

效果展示

先「听」为快,这里展示了一些 SeedFoley 生成的视频音效效果。

技术方案

SeedFoley 是一种端到端的视频音效生成架构,通过融合时空视频特征与扩散生成模型,实现了音效和视频的高度同步。首先,用固定的视频帧率对视频序列进行抽帧提取,然后使用一个视频编码器提取视频的表征信息,并通过多层线形变换将视频表征投射到条件空间,在改进的扩散模型框架中构建音效生成路径。

在训练过程,提取语音和音乐相关标签,作为 multi conditions 的形式输入,可以将音效和非音效进行解耦。SeedFoley 能支持可变长度的视频输入,并且在音效准确性,音效同步性和音效匹配度等指标上都取得了领先水平。

图 1:SeedFoley 的模型架构

视频编码器

SeedFoley 的视频编码器,采用了快慢特征组合的方式,在高帧率上提取帧间的局部运动信息,在低帧率上提取视频的语义信息。通过将快慢特征组合,既保留了运动特征,有效降低计算成本。通过这种方式,能在低计算资源性实现 8fps 的帧级别视频特征提取,实现精细动作定位。最后利用 Transformer 结构融合快慢特征,实现视频的时空特征提取。在提升训练效果和训练效率上,SeedFoley 通过在一个批次中引入多个困难样本,显著提升了语义对齐效果,同时使用了 sigmoid loss 而非 softmax loss,能在更低的资源上实现媲美大批次训练的效果。

图 2:SeedFoley 的视频编码器

音频表征模型

对于扩散模型而言,通常采用 VAE 生成的潜在表征(latent representation)作为音频特征编码。与基于梅尔频谱(mel-spectrum)的 VAE 模型不同,SeedFoley 采用原始波形(raw waveform)作为输入,经过编码后得到 1D 的表征,比传统 mel-VAE 模型在重构和生成建模上更有优势。这里,音频采用了 32k 的采样率,以确保高频信息的保留。每秒钟的音频提取到 32 个音频潜在表征,可以有效提升音频在时序上的分辨率,提升音效的细腻程度。

SeedFoley 的音频表征模型采用了两阶段联合训练策略:在第一阶段使用掩码策略,将音频表征中的相位信息进行剥离,将去相位后的潜在表征作为扩散模型的优化目标;在第二阶段则使用音频解码器从去相位表征中重建相位信息。这个做法可以有效降低扩散模型对表征的预测难度,最终实现音频潜在表征的高质量生成和还原。

扩散模型

SeedFoley 采用 Diffusion Transformer 框架,通过优化概率路径上的连续映射关系,实现了从高斯噪声分布到目标音频表征空间的概率匹配。相较于传统扩散模型依赖马尔可夫链式采样的特性,SeedFoley 通过构建连续变换路径,有效减少推理步数,降低推理成本。

在训练阶段,将视频特征与音频语义标签分别编码为隐空间向量;通过通道维度拼接(Channel-wise Concatenation)将二者与时间编码(Time Embedding)及噪声信号进行混合,形成联合条件输入。该设计通过显式建模跨模态时序相关性,有效提升了音效和视频画面在时序上的一致性以及内容的理解能力。

在推理阶段,通过调整 CFG 系数可调整视觉信息的控制强度以及生成质量之间的关系。通过迭代式优化噪声分布,将噪声逐步转换为目标数据分布。通过将人声以及音乐标签进行强行设定,可以有效避免音效中夹杂人声或者背景音乐的可能性,提升音效的清晰度和质感。最后将音频表征输入到音频解码中,得到音效音频。

结语

SeedFoley 实现了视频内容与音频生成的深度融合,能够精确提取视频帧级视觉信息,通过分析多帧画面信息,精准识别视频中的发声主体及动作场景。无论是节奏感强烈的音乐瞬间,还是电影中的紧张情节,都能精准卡点,营造出身临其境的逼真体验;另外,SeedFoley 可智能区分动作音效和环境音效,显著提升视频的叙事张力和情感传递效率。

「AI 音效」功能已上线即梦,用户使用即梦生成视频后,选择「AI 音效」功能,即可生成 3 个专业级音效方案。在 AI 视频,生活 Vlog、短片制作和游戏制作等高频场景中,能有效摆脱 AI 视频的「无声尴尬」,便捷地制作出配有专业音效的高质量视频。

(资料源于网络并整理)

———————————————————————————————

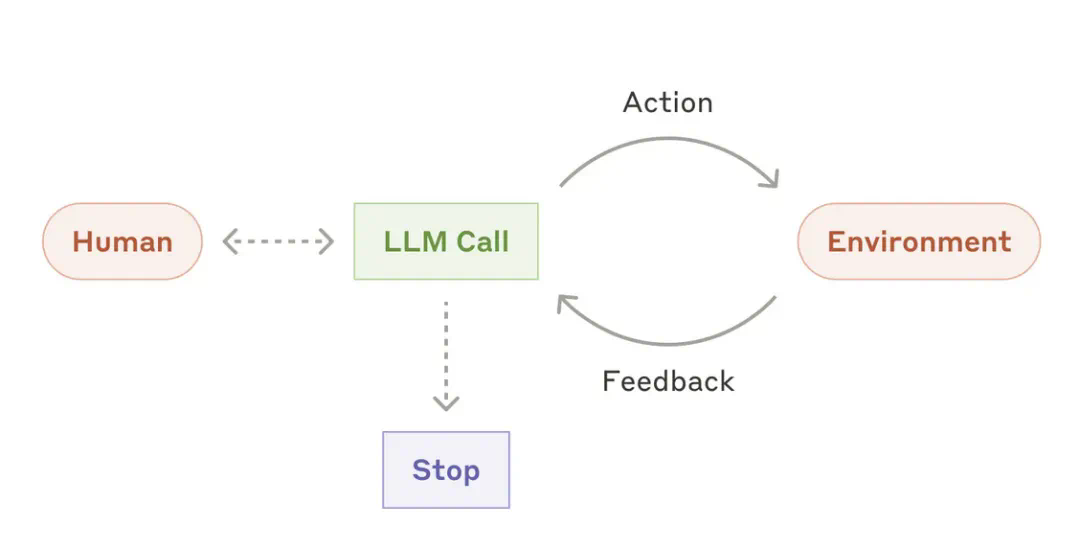

过去几年里,关于 AI 发展下一个周期会是什么,人们有很多猜测:Agent(智能体)?Reasoner(推理器)?真正的多模态?

原文链接:vintagedata.org

我认为是时候下定论了:模型即产品。当前研究和市场发展的所有因素都指向这个方向。

- 通用模型的 scaling 正在停滞。这正是 GPT-4.5 发布背后传达的信息:能力在线性增长,而计算成本却呈几何曲线增长。即使过去两年训练和基础设施效率的提升不小,OpenAI 也无法部署这个巨型模型 —— 至少定价远远不是用户能承受的。

- 某些已有方法的训练效果远超预期。强化学习和推理的结合意味着模型突然开始学习任务。这不是机器学习,也不是基础模型,而是一种秘密的第三种东西。甚至是小模型的数学能力也突然变得好得吓人。这让编程模型不再仅仅生成代码,而是自己管理整个代码库。这能让 Claude 在上下文信息很少且没有专门训练的情况下玩《宝可梦》游戏。

- 推理成本急剧下降。DeepSeek 最近的优化意味着所有可用的 GPU 加起来可以支撑全球用户每天让前沿模型输出 10k token。我们现在还远没有这么大的需求。对模型提供商来说,卖 token 赚钱的思路不再有效了:他们必须向价值链的更高处移动。

这也是一个令人不安的方向。所有投资者都在押注应用层。在 AI 进化的下一阶段,应用层可能是最先被自动化和颠覆的。

未来模型的形态

如果模型即产品,单打独斗的开发方式将不再可行。搜索和代码领域是容易摘取的果实:作为过去两年的主要应用场景,市场已接近成熟,你可以在几个月内推出新的 cursor 产品。然而,未来许多最具盈利潜力的 AI 应用场景尚未发展到这一阶段 —— 想想那些仍然主导全球经济大部分的基于规则的系统。拥有跨领域专业知识和高度专注的小型团队可能最适合解决这些问题 —— 最终在完成基础工作后成为潜在的收购对象。我们可能会在 UI 领域看到类似的发展路径:一些优先合作伙伴获得闭源专业模型的独家 API 访问权,前提是他们为未来的业务收购做好准备。

至今我还没有提及 DeepSeek 或中国的实验室。原因很简单,DeepSeek 已经更进一步:它不仅是作为产品的模型,而是作为通用基础设施层。与 OpenAI 和 Anthropic 一样,梁文锋公开了他的计划:

我们认为当前阶段是技术创新的爆发期,而不是应用的爆发期 (...)如果能形成完整的产业上下游,我们就没必要自己做应用。当然,如果需要,我们做应用也没障碍,但研究和技术创新永远是我们第一优先级。

在这个阶段,仅专注于应用开发就像是「用上一场战争的将军打下一场战争」。恐怕许多人甚至还没意识到,上一场战争已经结束了。

体验链接:www.aippt.cn

本期主播:蛋酥酥/猫猫

后期:丹尼播客制作

制作人:蛋酥酥

录制支持:KUEENDOM

粉丝群微信:luxnirvana(备注播客过来哒)

编辑单集

2.3

03:54 ‧ 2025-03-09

单集封面

点击上传封面

或打开资源库

关联追光任务

选择任务

空空如也

暂无小宇宙热门评论