时长:

95分钟

播放:

66

发布:

10个月前

主播...

简介...

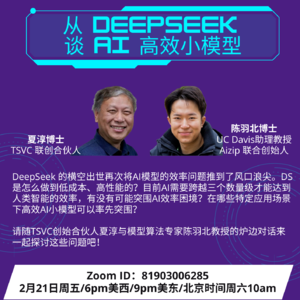

2月22日TSVC举办了《打造下一个独角兽》讲座第38讲。DeepSeek的横空出世再次将AI模型的效率问题推到了风口浪尖。DS是怎么做到低成本、高性能的?目前AI需要跨越三个数量级才能达到人类智能的效率,有没有可能突围AI效率困境?在哪些特定应用场景下高效AI小模型可以率先突围?请随TSVC创始合伙人夏淳与模型算法专家陈羽北教授的炉边对话来一起探讨这些问题吧!

嘉宾:

陈羽北,加州大学戴维斯分校电子与计算机工程系助理教授。本科毕业于清华大学电子系,博士师从加州大学伯克利分校计算神经科学专家Bruno Olshausen教授,博士后师从纽约大学深度学习专家Yann LeCun教授。研究方向为无监督学习与计算神经科学,主要探索人脑及机器学习中无监督学习的基本原理。博士期间获得美国自然科学研究生奖学金,研究工作获得2023年国际表征学习大会(ICLR)杰出论文提名,2020年在硅谷联合创办人工智能公司Aizip.ai。

夏淳博士是TSVC联合创始合伙人,硅谷成功的系列创业家。曾先后创办三家科技公司,研发销售世界上最早的个性化营销系统,以及国际领先的边缘容器技术。他曾任IT行业一代巨头Sun Microsystems首席架构师,是早期云计算技术奠基者之一。除了云计算、芯片、人工智能、智能制造等硬科技投资,夏淳博士在设计和创意领域颇有造诣,并且对社交媒体和社群经济的跨界文化有深入研究。夏淳博士是清华企业家协会(TEEC)创始会员之一,曾任北美分会首任主席。自2001年,他长年服务于青年学生的培养辅导,持续担任清华大学思源计划导师、清华创业孵化器x-lab的创业导师、清华创+逆向创新中心主任,并在硅谷创建了激励青年学生创新创业的公益基金TSVC Giving Fund。夏淳博士是清华大学电子工程学士及计算机硕士,并在美国UIUC大学获得计算机博士。

以下为正文:

03:04 今天参加本次活动的朋友们都比较踊跃,对于DeepSeek有很大的兴趣。在2024年12月的时候,TSVC在LinkedIn就发布过一个帖子,当时DeepSeek还没完全炒热,TSVC便已经关注到它。他们之所以关注这件事,是因为在两年以前,TSVC就清楚有效率的问题。这是从TSVC投资的Aizip陈教授那里学到的,并了解到该公司是专门解决效率方面的问题,这是一个全新的赛道,他们为此非常兴奋。那么DeepSeek这一路走来,证明了这个方向的重要性和成功性。

04:10 陈教授,从你的角度观察,DeepSeek为什么会聚焦到AI的效率问题?这个大背景是什么情况?因为你是长期在学术界多年,那么关于效率方面学术界是什么时候就开始研究了?

陈教授指出,关于效率的问题,可以从多个角度进行探讨。第一,对于大模型来讲,效率会直接翻译成它的价格,如果效率很低,价格就会很高。对于大模型公司,不仅是提供自己独立平台上的应用,还提供AI的API接口,它的每一次计算,每个token所要花费的算力,会直接翻译成它的价格。对于DeepSeek这样的公司,既做大模型同时也做小模型,这点非常重要,因为既要提供服务和应用,还需要首先考虑到效率的问题。

第二,大模型每次训练已经变得非常贵了,以DeepSeek的一次训练计算,V3模型高达500多万美金,基本上价格是按照一至两美元一小时,用A100大概是一美元一小时,如果是H100在两美元一小时。通常数量比较小,拿到的价格还要再高一些。那么,如果可以提高它的效率,每一次训练的价格也会下降许多。一次训练需要花费500万美金,训练多次它的价格也会相应地增长,所以效率很重要。

除此之外,对DeepSeek的关注度比较高的一点,除了V3模型是去年12月发布的,还有这次的R1模型,其中主打推理和规划的能力。一旦使用在处理问题,其本质是搜索问题,那么搜索其实是非常贵的,如果搜索效率低,开销就增大。举个简单的例子,用DeepSeek R1来解数学题,随便列出一道题365×34-3+8÷2=767,并对模型说“请加上一对括号,使得这个公式变成正确的”,那么这个模型会去搜索,如果问题稍微复杂一些,更多时候它需要搜索到十五分钟,这样一个问题会用到十万个token,甚至可能更多,如果它的效率很低,那么在使用的过程中,它的开销也会大幅度增加。对于一个商业化的产品,提高效率和降低价格是非常重要的。

从学术界的角度来讲,效率也是非常引人入胜的问题。看自然智能,是指人类和一些动物所具有的智能。相比现在的AI大模型,实际上从功耗或是模型的尺寸,以及从学习的效率来讲,大概都有三个数量级的差距,甚至可能更多。因此,不管是从商业还是从学术的价值来讲,效率都是一个至关重要的问题。而且在早期工业革命时,效率也是一个核心问题,当蒸汽机的第一次出现,它以前的功耗和今天机器的效率作对比,也是将近差三个数量级的。

夏博士补充道,在他的印象中,AI的学术界关注效率方面的问题,斯坦福在研究模型压缩方面至少超过十年了。

陈教授指出,关于压缩方面的问题其实并不是最近发生的,早在1989年,蒙特利尔大学教授,也是魁北克省Mila人工智能研究所的科学主任的Yoshua Bengio 教授,参与发表了一篇很有意思的文章《Optimal Brain Damage》,压缩模型从而减少它的一些参数,使得它的精度不变。应该是在80年代末,90年代初就在研究相关问题了。现在AI的逐渐发展,使得模型压缩变成了一个很有用的技术。但模型压缩仅是一小部分,除了模型压缩以外,还有一系列的问题需要攻克。

10:11 大家比较关心的DeepSeek取得的这些成就证明了哪些方法是有效的?记得陈教授原来讲过AI有三种效率,具体是哪三种?DeepSeek的效率又体现在哪一类?夏博士最早是在去年夏天关注到MoE,并有机会遇到李开复,说他们公司零一就是用了MoE模型取得超高的效率,这是最早了解到MoE完全可以与当时的OpenAI o1大模型相比,这是一个挺好的方向。请陈教授讲讲三个提高效率的方向。

陈教授表示,他对DeepSeek的了解有限,有更多人可能更早的时候就关注他们了,也知道他们一直在发表文章,但真正开始关注是从最近的V3模型开始,他认为V3的结果已经做得非常好了。具体而言,DeepSeek做了两件不错的事情。第一件,是整体的MoE模型,在不同expert上面的load balance不是很均衡,在这个问题上做了一些工作,使得它的load balance变得比较均衡。第二件,是DeepSeek一直在探索模型的结构上是否有可改进的空间,超过一般的注意力机制,V3模型做了一个latent space的Multi Token Attention,这个Meta之前也做过类似的工作,对于效率也有很大的提高。并且前不久,发布了稀疏注意力机制,这个可能要进一步地提高它的效率。

当你做了这两件事情以后,其实都是对模型的结构以及运算load balance做出的一些改进,非常有效地使得MoE它可以获得更好的性能。除此之外,还做了一些底层的事情,对于AI团队来讲永远都是两部分,一个是算法部分,一个是系统部分,两者缺一不可。从早年Google的时期,人们就意识到相关问题,计算和AI算法同样重要。这个逻辑与当年的Google对于Transformer架构的结构支持表现出了相似性,如果同样使用CUDA的kernel支持的话,效率就会非常低。对于做了结构上的改进以后,硬件的使用效率就会较差,所以DeepSeek在改进架构的同时,有一个非常强大的系统团队可以做到写底层代码,把改进后的架构依然做得高效。使得在V3的大模型上就已经获得了相当不错的成绩,而v3是个6000多亿参数的大模型。

最近把DeepSeek推到了风口浪尖上实际上是R1,做了比较直观的搜索功能,基本上是用了自己定义对于数学问题的推理能力。对于数学问题可以非常方便地设立奖励函数,这是一件讨巧的事,主要满足以下两个要求:一个是格式的正确性;第二个是与正确答案完全一样,并且可以计算出正确答案。因此,这两种是最简单的奖励机制。在这基础之上加入思考机制,让模型本身有思考的过程,犹如加了一块白板基本就有推理能力。

他认为,由于V3模型的能力已经足够好,使得在搜索的过程中精度比较高,可以做到自发的方式进行搜索,来获得比较好的推理能力。至于怎么做,又是一个非常简单的方法,对于每一个问题设置100条答案,再从这里面寻找是否有答对的迹象,从这些答对的情况下做出反馈。奖励函数实际上是比较直观的,所以可以用自发的方式。如果看training code一开始的起点不是零,而是有10%左右已经是比较高了,对于盲猜或者直接出100条这样的方式,已经有如此高的概率,其实是把稀疏奖励的问题几乎绕过去了。这是第二个取得的推理能力。

第三个除了推理能力以外,对于R1的小模型还做了蒸馏技术,把大模型的能力通过知识蒸馏技术用在小模型上,这点很有意思。证明在DeepSeek的大模型上,虽然用小模型无法用自发的方式学习到推理能力,但是如果把结果给你,小模型实际上是可以学到,很好的推理能力。让它自己去盲猜,自发方式不好做,因为本身小的模型不够好,但是可以用大模型的方式把正确的答案蒸馏到更小的模型中,并且实现推理能力,他认为这是可以去做的。

夏博士表示,这些都是非常明显的,并且收获了很好的结果。顺着这点往下讲的就是做出R1的小模型了,那么Aizip是聚焦在小模型以及微模型方面,TSVC基金在两年前就开始布局,认为这是一个全新的赛道,在AI领域关注效率的问题,并追求模型的小型化是一个重要趋势。

因字数限制,更多内容请收听音频

欢迎关注“TSVC“微信公众号观看视频,了解更多早期创投相关话题的干货内容!

加入日常交流群请看海报右下角二维码,添加TSVC小助手,获取更多分享。

嘉宾:

陈羽北,加州大学戴维斯分校电子与计算机工程系助理教授。本科毕业于清华大学电子系,博士师从加州大学伯克利分校计算神经科学专家Bruno Olshausen教授,博士后师从纽约大学深度学习专家Yann LeCun教授。研究方向为无监督学习与计算神经科学,主要探索人脑及机器学习中无监督学习的基本原理。博士期间获得美国自然科学研究生奖学金,研究工作获得2023年国际表征学习大会(ICLR)杰出论文提名,2020年在硅谷联合创办人工智能公司Aizip.ai。

夏淳博士是TSVC联合创始合伙人,硅谷成功的系列创业家。曾先后创办三家科技公司,研发销售世界上最早的个性化营销系统,以及国际领先的边缘容器技术。他曾任IT行业一代巨头Sun Microsystems首席架构师,是早期云计算技术奠基者之一。除了云计算、芯片、人工智能、智能制造等硬科技投资,夏淳博士在设计和创意领域颇有造诣,并且对社交媒体和社群经济的跨界文化有深入研究。夏淳博士是清华企业家协会(TEEC)创始会员之一,曾任北美分会首任主席。自2001年,他长年服务于青年学生的培养辅导,持续担任清华大学思源计划导师、清华创业孵化器x-lab的创业导师、清华创+逆向创新中心主任,并在硅谷创建了激励青年学生创新创业的公益基金TSVC Giving Fund。夏淳博士是清华大学电子工程学士及计算机硕士,并在美国UIUC大学获得计算机博士。

以下为正文:

03:04 今天参加本次活动的朋友们都比较踊跃,对于DeepSeek有很大的兴趣。在2024年12月的时候,TSVC在LinkedIn就发布过一个帖子,当时DeepSeek还没完全炒热,TSVC便已经关注到它。他们之所以关注这件事,是因为在两年以前,TSVC就清楚有效率的问题。这是从TSVC投资的Aizip陈教授那里学到的,并了解到该公司是专门解决效率方面的问题,这是一个全新的赛道,他们为此非常兴奋。那么DeepSeek这一路走来,证明了这个方向的重要性和成功性。

04:10 陈教授,从你的角度观察,DeepSeek为什么会聚焦到AI的效率问题?这个大背景是什么情况?因为你是长期在学术界多年,那么关于效率方面学术界是什么时候就开始研究了?

陈教授指出,关于效率的问题,可以从多个角度进行探讨。第一,对于大模型来讲,效率会直接翻译成它的价格,如果效率很低,价格就会很高。对于大模型公司,不仅是提供自己独立平台上的应用,还提供AI的API接口,它的每一次计算,每个token所要花费的算力,会直接翻译成它的价格。对于DeepSeek这样的公司,既做大模型同时也做小模型,这点非常重要,因为既要提供服务和应用,还需要首先考虑到效率的问题。

第二,大模型每次训练已经变得非常贵了,以DeepSeek的一次训练计算,V3模型高达500多万美金,基本上价格是按照一至两美元一小时,用A100大概是一美元一小时,如果是H100在两美元一小时。通常数量比较小,拿到的价格还要再高一些。那么,如果可以提高它的效率,每一次训练的价格也会下降许多。一次训练需要花费500万美金,训练多次它的价格也会相应地增长,所以效率很重要。

除此之外,对DeepSeek的关注度比较高的一点,除了V3模型是去年12月发布的,还有这次的R1模型,其中主打推理和规划的能力。一旦使用在处理问题,其本质是搜索问题,那么搜索其实是非常贵的,如果搜索效率低,开销就增大。举个简单的例子,用DeepSeek R1来解数学题,随便列出一道题365×34-3+8÷2=767,并对模型说“请加上一对括号,使得这个公式变成正确的”,那么这个模型会去搜索,如果问题稍微复杂一些,更多时候它需要搜索到十五分钟,这样一个问题会用到十万个token,甚至可能更多,如果它的效率很低,那么在使用的过程中,它的开销也会大幅度增加。对于一个商业化的产品,提高效率和降低价格是非常重要的。

从学术界的角度来讲,效率也是非常引人入胜的问题。看自然智能,是指人类和一些动物所具有的智能。相比现在的AI大模型,实际上从功耗或是模型的尺寸,以及从学习的效率来讲,大概都有三个数量级的差距,甚至可能更多。因此,不管是从商业还是从学术的价值来讲,效率都是一个至关重要的问题。而且在早期工业革命时,效率也是一个核心问题,当蒸汽机的第一次出现,它以前的功耗和今天机器的效率作对比,也是将近差三个数量级的。

夏博士补充道,在他的印象中,AI的学术界关注效率方面的问题,斯坦福在研究模型压缩方面至少超过十年了。

陈教授指出,关于压缩方面的问题其实并不是最近发生的,早在1989年,蒙特利尔大学教授,也是魁北克省Mila人工智能研究所的科学主任的Yoshua Bengio 教授,参与发表了一篇很有意思的文章《Optimal Brain Damage》,压缩模型从而减少它的一些参数,使得它的精度不变。应该是在80年代末,90年代初就在研究相关问题了。现在AI的逐渐发展,使得模型压缩变成了一个很有用的技术。但模型压缩仅是一小部分,除了模型压缩以外,还有一系列的问题需要攻克。

10:11 大家比较关心的DeepSeek取得的这些成就证明了哪些方法是有效的?记得陈教授原来讲过AI有三种效率,具体是哪三种?DeepSeek的效率又体现在哪一类?夏博士最早是在去年夏天关注到MoE,并有机会遇到李开复,说他们公司零一就是用了MoE模型取得超高的效率,这是最早了解到MoE完全可以与当时的OpenAI o1大模型相比,这是一个挺好的方向。请陈教授讲讲三个提高效率的方向。

陈教授表示,他对DeepSeek的了解有限,有更多人可能更早的时候就关注他们了,也知道他们一直在发表文章,但真正开始关注是从最近的V3模型开始,他认为V3的结果已经做得非常好了。具体而言,DeepSeek做了两件不错的事情。第一件,是整体的MoE模型,在不同expert上面的load balance不是很均衡,在这个问题上做了一些工作,使得它的load balance变得比较均衡。第二件,是DeepSeek一直在探索模型的结构上是否有可改进的空间,超过一般的注意力机制,V3模型做了一个latent space的Multi Token Attention,这个Meta之前也做过类似的工作,对于效率也有很大的提高。并且前不久,发布了稀疏注意力机制,这个可能要进一步地提高它的效率。

当你做了这两件事情以后,其实都是对模型的结构以及运算load balance做出的一些改进,非常有效地使得MoE它可以获得更好的性能。除此之外,还做了一些底层的事情,对于AI团队来讲永远都是两部分,一个是算法部分,一个是系统部分,两者缺一不可。从早年Google的时期,人们就意识到相关问题,计算和AI算法同样重要。这个逻辑与当年的Google对于Transformer架构的结构支持表现出了相似性,如果同样使用CUDA的kernel支持的话,效率就会非常低。对于做了结构上的改进以后,硬件的使用效率就会较差,所以DeepSeek在改进架构的同时,有一个非常强大的系统团队可以做到写底层代码,把改进后的架构依然做得高效。使得在V3的大模型上就已经获得了相当不错的成绩,而v3是个6000多亿参数的大模型。

最近把DeepSeek推到了风口浪尖上实际上是R1,做了比较直观的搜索功能,基本上是用了自己定义对于数学问题的推理能力。对于数学问题可以非常方便地设立奖励函数,这是一件讨巧的事,主要满足以下两个要求:一个是格式的正确性;第二个是与正确答案完全一样,并且可以计算出正确答案。因此,这两种是最简单的奖励机制。在这基础之上加入思考机制,让模型本身有思考的过程,犹如加了一块白板基本就有推理能力。

他认为,由于V3模型的能力已经足够好,使得在搜索的过程中精度比较高,可以做到自发的方式进行搜索,来获得比较好的推理能力。至于怎么做,又是一个非常简单的方法,对于每一个问题设置100条答案,再从这里面寻找是否有答对的迹象,从这些答对的情况下做出反馈。奖励函数实际上是比较直观的,所以可以用自发的方式。如果看training code一开始的起点不是零,而是有10%左右已经是比较高了,对于盲猜或者直接出100条这样的方式,已经有如此高的概率,其实是把稀疏奖励的问题几乎绕过去了。这是第二个取得的推理能力。

第三个除了推理能力以外,对于R1的小模型还做了蒸馏技术,把大模型的能力通过知识蒸馏技术用在小模型上,这点很有意思。证明在DeepSeek的大模型上,虽然用小模型无法用自发的方式学习到推理能力,但是如果把结果给你,小模型实际上是可以学到,很好的推理能力。让它自己去盲猜,自发方式不好做,因为本身小的模型不够好,但是可以用大模型的方式把正确的答案蒸馏到更小的模型中,并且实现推理能力,他认为这是可以去做的。

夏博士表示,这些都是非常明显的,并且收获了很好的结果。顺着这点往下讲的就是做出R1的小模型了,那么Aizip是聚焦在小模型以及微模型方面,TSVC基金在两年前就开始布局,认为这是一个全新的赛道,在AI领域关注效率的问题,并追求模型的小型化是一个重要趋势。

因字数限制,更多内容请收听音频

欢迎关注“TSVC“微信公众号观看视频,了解更多早期创投相关话题的干货内容!

加入日常交流群请看海报右下角二维码,添加TSVC小助手,获取更多分享。

评价...

空空如也

小宇宙热门评论...

暂无小宇宙热门评论