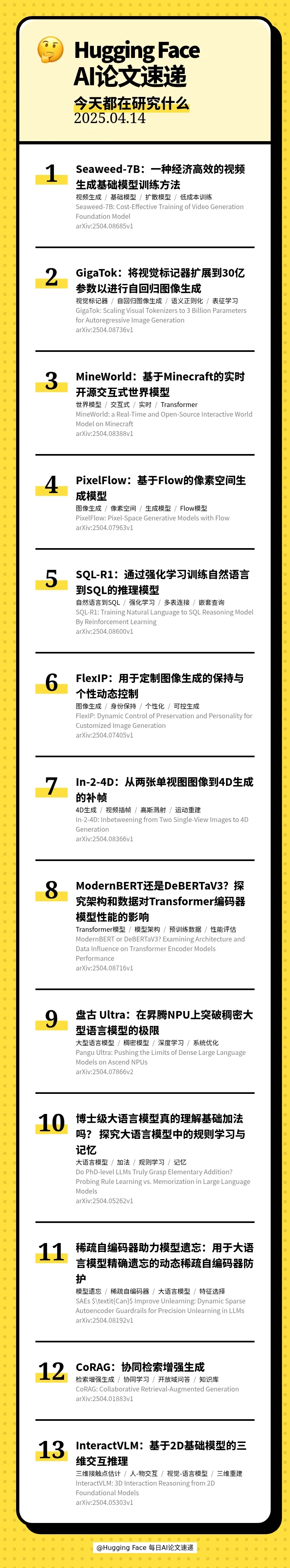

本期的 13 篇论文如下:

[00:24] 🎬 Seaweed-7B: Cost-Effective Training of Video Generation Foundation Model(Seaweed-7B:一种经济高效的视频生成基础模型训练方法)

[01:00] 🖼 GigaTok: Scaling Visual Tokenizers to 3 Billion Parameters for Autoregressive Image Generation(GigaTok:将视觉标记器扩展到30亿参数以进行自回归图像生成)

[01:42] 🎮 MineWorld: a Real-Time and Open-Source Interactive World Model on Minecraft(MineWorld:基于Minecraft的实时开源交互式世界模型)

[02:25] 🖼 PixelFlow: Pixel-Space Generative Models with Flow(PixelFlow:基于Flow的像素空间生成模型)

[03:05] 🤖 SQL-R1: Training Natural Language to SQL Reasoning Model By Reinforcement Learning(SQL-R1:通过强化学习训练自然语言到SQL的推理模型)

[03:51] 🎨 FlexIP: Dynamic Control of Preservation and Personality for Customized Image Generation(FlexIP:用于定制图像生成的保持与个性动态控制)

[04:30] 🎬 In-2-4D: Inbetweening from Two Single-View Images to 4D Generation(In-2-4D:从两张单视图图像到4D生成的补帧)

[05:05] 🤔 ModernBERT or DeBERTaV3? Examining Architecture and Data Influence on Transformer Encoder Models Performance(ModernBERT还是DeBERTaV3?探究架构和数据对Transformer编码器模型性能的影响)

[05:42] 🚀 Pangu Ultra: Pushing the Limits of Dense Large Language Models on Ascend NPUs(盘古 Ultra:在昇腾NPU上突破稠密大型语言模型的极限)

[06:21] 🤔 Do PhD-level LLMs Truly Grasp Elementary Addition? Probing Rule Learning vs. Memorization in Large Language Models(博士级大语言模型真的理解基础加法吗? 探究大语言模型中的规则学习与记忆)

[07:11] 🛡 SAEs $\textit{Can}$ Improve Unlearning: Dynamic Sparse Autoencoder Guardrails for Precision Unlearning in LLMs(稀疏自编码器助力模型遗忘:用于大语言模型精确遗忘的动态稀疏自编码器防护)

[07:52] 🤝 CoRAG: Collaborative Retrieval-Augmented Generation(CoRAG:协同检索增强生成)

[08:29] 🤝 InteractVLM: 3D Interaction Reasoning from 2D Foundational Models(InteractVLM:基于2D基础模型的三维交互推理)

【关注我们】

您还可以在以下平台找到我们,获得播客内容以外更多信息

小红书: AI速递

空空如也

暂无小宇宙热门评论