时长:

39分钟

播放:

3.13万

发布:

1年前

主播...

简介...

Sora 我想了很久该怎么讲,也问了一些人,但其实技术层面的解读已经很多了,产品上也没有开放,再去赘述也没什么意思,本质上 Sora 还是模型能力的一种延续,所以在这期里,我们把 Sora、英伟达 等统一到了一个大的叙事逻辑之下来讨论。

我们讲了 Sora 的意义和影响是什么,英伟达持续飙涨的背后原因是什么 (以及是否可持续?),还讨论了 AI 世界 (尤其是海外) 到底在发生什么,以及在这个叙事下不同阶段的逻辑、可能产生的变化是什么。相信听完这期播客,大家都能从宏观上对整体的 AI 发展有一个把握,再去看各种新模型、新热点也都能有更好的对号入座的理解。

如播客中所讲,我们目前其实是处于 1.0 时代到 1.5 时代的交替过程中,我们也十分期盼 2.0 时代 AI 真正爆发的到来。

【人类博物馆】

导游:曲凯,42章经创始人

九号珍藏:莫傑麟,家族办公室资深从业者

【时光机】

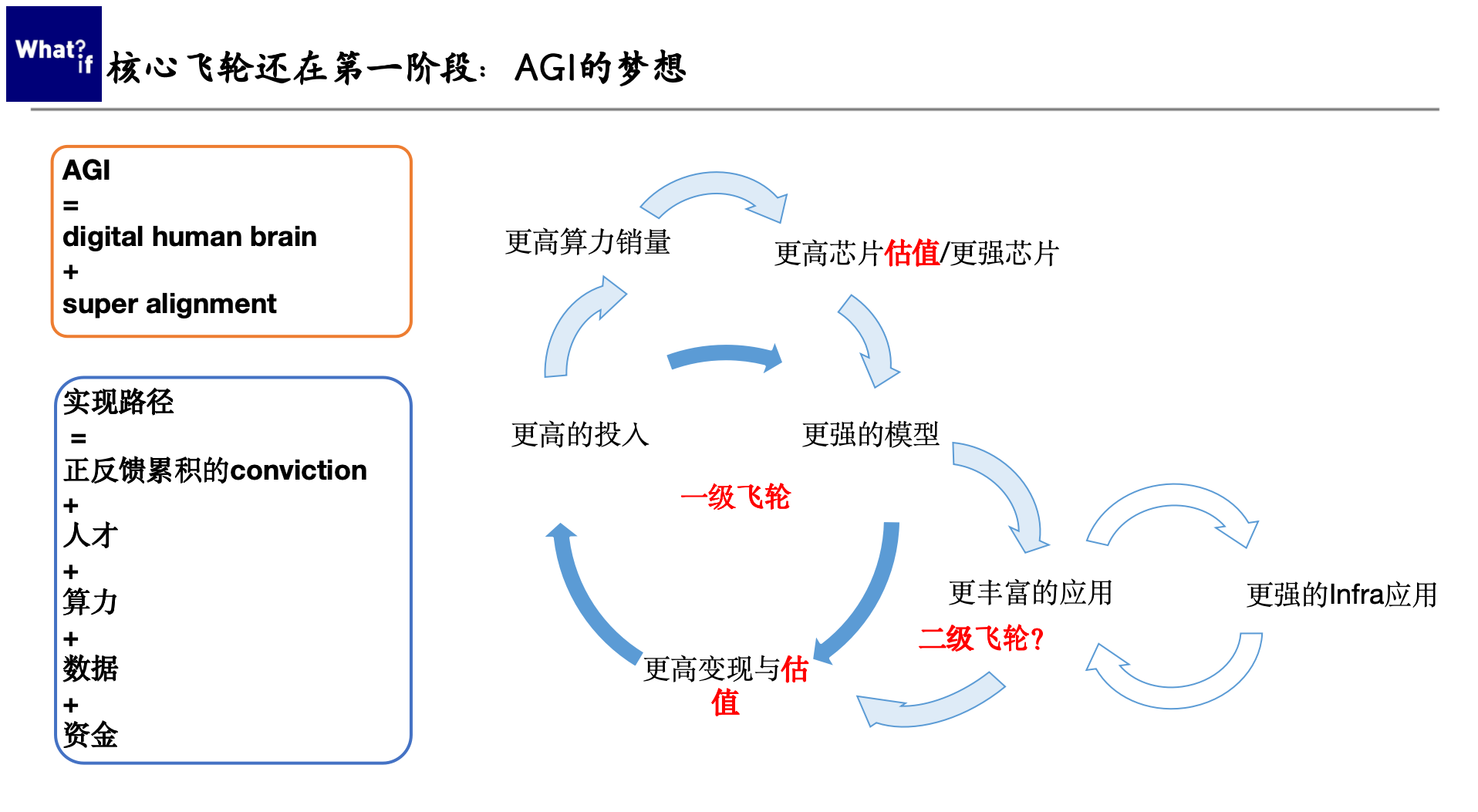

- 1:33 如何理解 AI 市场的核心逻辑?

- 1:42 AI 1.0 阶段的叙事逻辑:Scaling law

- 4:41 AI 1.5 阶段的叙事逻辑:Scale in & Scale out

- 5:56 AI 2.0 阶段的叙事逻辑:应用的大爆发

- 9:28 AI 应用目前处于一个试探玩法的阶段

- 11:10 国内这波创始人的质量是相当高的

- 12:51 AI 投资的三种表现

- 19:16 评估英伟达的股价,要同时具备微观、中观、宏观三种视角

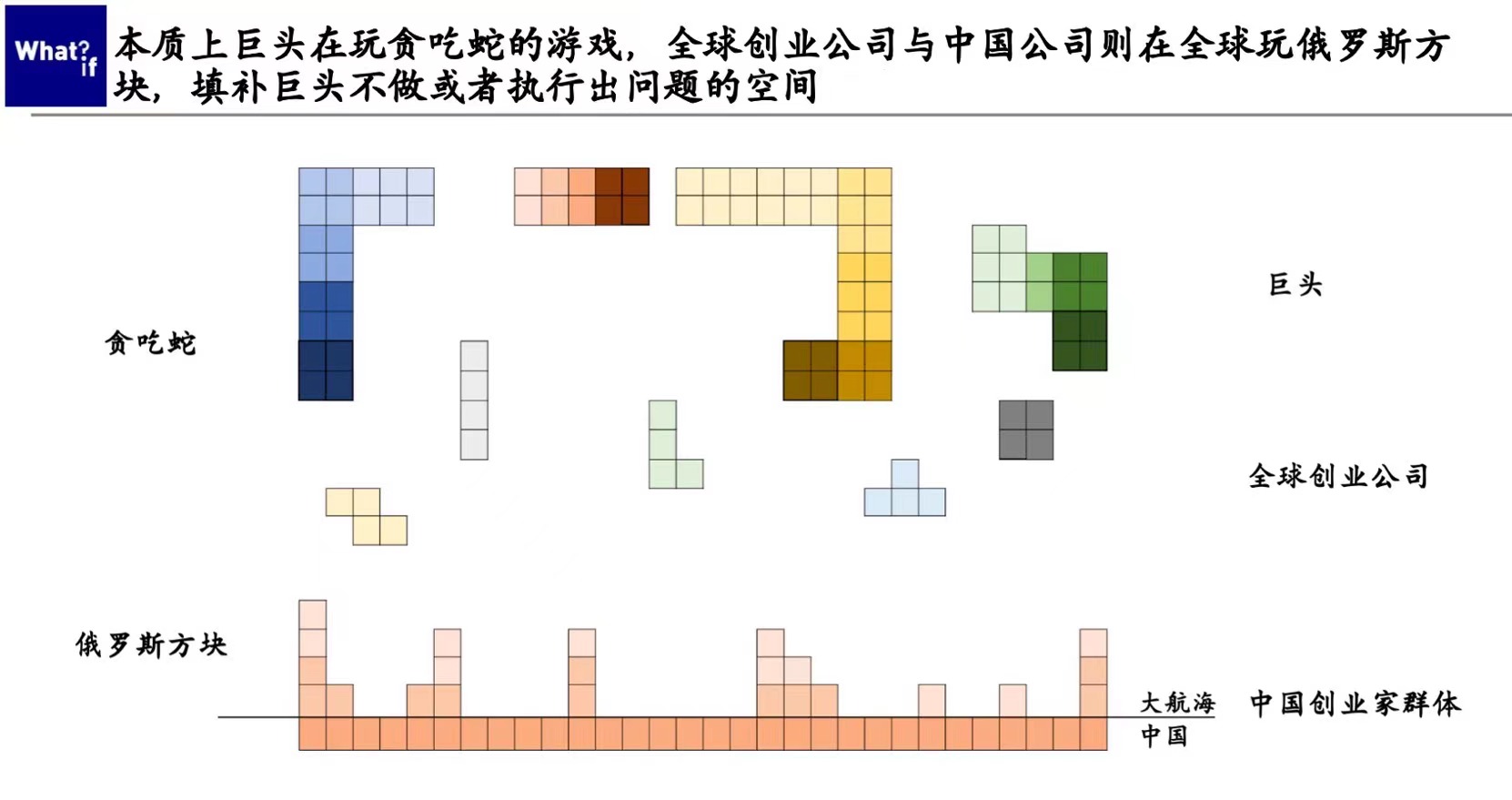

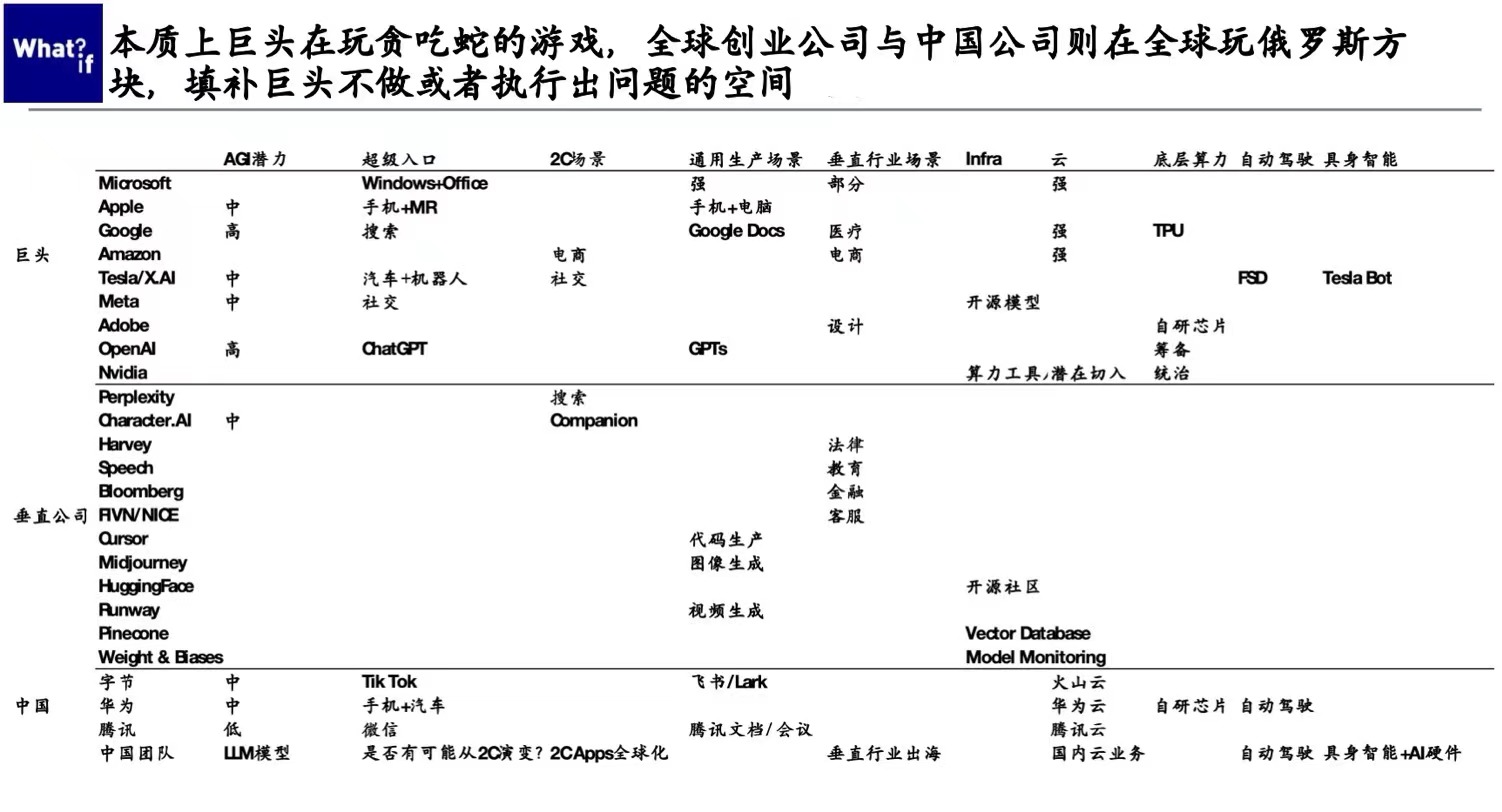

- 21:20 贪吃蛇与俄罗斯方块的游戏

- 22:23 大公司与创业公司的博弈像一场「球球大作战」的游戏

- 29:57 国内大模型和 OpenAI 之间的差距到底是在缩进还是在拉远?

- 31:31 关于 Sora 的几点启发

- 33:12 Sam Altman 是面壁人,Elon Musk 是破壁人,Jensen Huang 是真正的受益人

- 35:24 行业开始洗牌,谁领先,谁出局,会是今年的核心看点

【The gang that made this happen】

- 制作人:Celia

- 剪辑:思娜

- 片头 bgm:Mondo Bongo - Joe Strummer & The Mescaleros

【Reference】

为什么我们开始乐观?关于经济发展的明线暗线、AI 与最佳实践 | 对谈莫傑麟

最后,我们的 AI 私董会也在持续报名中,目前已经聚集了一批市场上最好的 AI 创始人,欢迎点击链接报名(里面也有目前已加入的成员名单,可点击查看)

评价...

空空如也

小宇宙热门评论...

JonathanYip

1年前

浙江

85

23:15 坐标国内某大厂,我们在硅谷调研了3次,最后的结论和嘉宾的结论完全一致,就是虽然很多技术我们也不懂,但能够依靠现有资源做的事情都先做,两期听完觉得嘉宾真的信息输入质量非常高

正好我是在云计算行业,我解释下什么是scale in(这是第一次在自媒体听到这么专业的词);这是云计算的terms,scale in指压缩能力强,scale out指压缩能力弱,比如Sora和现在llm算法一个核心的算法能力是压缩能力,没有压缩能力的算法实质上会被scaling law淘汰,因为今天的算法不只是考虑软件,而是要考虑硬件和存储,实际上scaling law这个阶段大部分是来自于transformer和硬件,存储问题很难解决,sora的惊艳表现很大程度上复用transformer得到了加速和压缩能力

再一次说:很专业和准确

JennyTsu

1年前

美国

22

硅谷这边已经暗流涌动了,身边的朋友要么去xai和苹果,要么去字节,也没什么人再提Anthropic了,建议放到podcast,质量很高 👍

HD991616o

1年前

新加坡

18

07:39 被北京同事转给我,听了1/3,忽然理解了某领导为什么年初开始这么大刀阔斧…. real 强🧱

今天吃什么呢152

1年前

江苏

13

23:09 球球大作战那个比喻也太棒了吧

刚下载不知道怎么起名

1年前

新加坡

12

17:41 从同事群看到,这是我听过讲sora我最认同的公开评论,sora只是多模态的一个过程产物,真正的难点在于工程上设计了怎么样的结构去获得一段时间的最优,这个设计或者技术的创新OpenAI不对外公布,很多公司很可能是摸不出来的,工程优势是无数最聪明的大脑组合起来的向前看,就每项技术可能都能读懂,但这不等同是能做出来?主讲人说是做投资管理,我理解是VC?

iConiq-Peter

1年前

英国

10

17:57 美国VC很fomo 这是我现在的感受 听到对AI很好的一期,不少创业者和投资人以大厂的动作或者加入某个大厂为支点

1-模型算力,秀肌肉和未来

2-更多人追赶、站队,不仅是秀肌肉

3-直到出现新的应用信号

下沙群岛三号

1年前

新加坡

9

35:07 好奇嘉宾是不是认识我们学校的刘子纬教授 听到了sora解读上很客观的解读 刘教授之前主要研究视觉 他的解读也是放在成本和速度 虽然算法可以做 但是怎么做到scaling 99%的公司是会倒下的

JonathanYip

1年前

浙江

8

37:31 我今天又听了一次,想补充一下,1.5叙事这个形容很巧妙,当软件赶上了,会发现可能基础设施、硬件是赶不上的,sora的最终成功哪怕不是Openai也一定是软硬件工程最强,这么去看1.5所指向的Scaling law和1的Scaling law内涵是不同的

陈不撕

1年前

上海

7

字节无疑是一个创业者警惕的对手。虽然他们速度 人才 资金都很强,但聊下来,他们还是奔着能做“最大”的东西去的。切入点和速度可能和创业者一样灵活,但是对天花板会有更多要求。

Howhow11

1年前

美国

7

嘉宾认知很高!scale in/up 是指把LLM做得更智能,做快, 先做大再做压缩。这是openai 最擅长的。scaling law还有一个维度是scale out 是把除了LLM外的其他ML都做大 做得更强,大家都只关注了scaling law的前者而忽略了scaling law的后者。后者的意义也许比前者大得多。后者与Jensen Huang 得accelerated computing不谋而合!

逍遥游不动了

1年前

美国

5

37:54 能不能准确定义一下什么是 scale out ,scale in 啊?有个 scaling law 就开始自己生造词,也太别扭了 🤦♂️

JASting

1年前

北京

5

05:10 领路者相信 Scaling law(只要资源持续投入一定会有技术进步一定会有大规模应用),也在牵引资本市场持续投入。23年是scaling law1.0时代,投资在大模型。24年最大的看点是scaling law演进过程中,现有产品会scale in 或out分别是谁。同时大部分人对未来更期待2.0的信号,2.0 时代就是关于应用,24年的投资会更多在应用层。

JASting

1年前

北京

5

10:09 目前AI应用时代是探索玩法、沉淀范式的阶段

王总今天喝了么

1年前

浙江

4

我来学习啦!

马修见莱濑

1年前

新加坡

4

32:29 讲得真好啊 好像一名很资深的工程师

琳琳Celia

1年前

山东

3

我好奇,如果不和Open AI来比,只是看整体的AI发展的话,国内和美国比是不是也是在拉远的?

HD132779l

1年前

广东

3

38:35 从杨植麟讲Sora那期过来,我之前在播客提到的某个大厂,提到的scale out,这个是每一次硬件的迭代中硬件厂商的收敛阶段,也就是靠采购算力来提高产出,简单来说模型本身在这个阶段或者场景中的重要性变弱,比如手机、电脑、甚至部分游戏都是这个曲线,真的很强的分析 👍

HD132779l

1年前

美国

3

29:04 参加GTC 回来mark这一期 大量预言 在GTC现场被很多朋友提到

小湖湖湖湖

1年前

北京

2

我最喜欢的歌!!!

willwangtf

1年前

未知

2

Scaling law 描述的是在系统规模变化时,系统的性质或行为如何随之变化的规律。这些规律在物理学、生物学、经济学等多个领域都有应用。Scaling laws 并不一定意味着边际递减,它们可以是线性的、亚线性的(边际递减),也可以是超线性的(边际递增)。

1. **线性Scaling Law**:如果一个系统的某个性质随着系统的规模线性增长,那么这个系统遵循线性的Scaling Law。例如,一个城市的总能量消耗可能与其人口数量成正比。

2. **亚线性Scaling Law(边际递减)**:在某些情况下,随着系统规模的增加,系统的某个性质增长得更慢。这种情况下,系统的边际效益是递减的。例如,大城市的基础设施(如道路、医院)的增加可能无法与人口增长保持同步,导致人均基础设施的减少。

3. **超线性Scaling Law(边际递增)**:在其他情况下,系统的某个性质可能随着规模的增加而加速增长,这意味着边际效益是递增的。例如,一个城市的创新活动可能随着人口的增加而加速,因为更多的人意味着更多的交流和合作机会。

总的来说,Scaling law 描述的是规模效应,它可以是递增的、递减的,也可以是恒定的,具体取决于系统的性质和所遵循的规律。

这次AI是哪一种?